均衡器LinuxLVS集群服务器实施详解

Linux Virtu al S erve r矛简称LVS。是由中国一个Linu x程序员发起的开发项目计划其实现目标是创建一个具有良好的扩展性、高可靠性、高性能和高可用性的基于Lin ux系统的服务器集群。

1.LVS系统结构与特点

使用LVS架设的服务器集群系统从体系结构上看是透明的最终用户只感觉到一个虚拟服务器.物理服务器之间可以通过高速的LAN或分布在各地的WAN相连。最前端是负载均衡器它负责将各种服务请求分发给后面的物理服务器让整个集群表现得象一个服务于同一IP地址的虚拟服务器。

LVS集群系统具有良好的可扩展性和高可用性。

可扩展性是指LVS集群建立后可以很容易地根据实际的需要增加或减少物理服务器。而高可用性是指当检测到服务器节点或服务进程出错、失效时集群系统能够自动进行适当的重新调整系统。cente2.LVS是如何工作的

Linux Virtual Server的主要是在负载均衡器上实现的负载均衡器是一台加了LVS Patch的2.2.x版内核的Linux系统。 LVS Patch可以通过重新编译内核的方法加入内核也可以当作一个动态的模块插入现在的内核中。

负载均衡器可以运行在以下三种模式下中的一种或几种

1Virtual Server via NAT VS-NAT用地址翻译实现虚拟服务器

2Virtual Server via IP Tunneling VS-TUN用IP隧道技术实现虚拟服务器

3Virtual Server via Direct Routing VS-DR用直接路由技术实现虚拟服务器。

另外还需要根据LVS应用对物理服务器进行恰当的配置。

以下将分别讲述一下三种模式的工作原理和优缺点。

2.1.Virtual server via NATVS-NAT

Virtual Serve r via NAT方法的最大优点是集群中的物理服务器可以使用任何支持T CP/IP操作系统物理服务器可以分配Internet的保留私有地址只有负载均衡器需要一个合法的IP地址。

这种实现方法的最大的缺点是扩展性有限。当服务器节点普通PC服务器数据增长到20个或更多时,负载均衡器将成为整个系统的瓶颈 因为所有的请求包和应答包都需要经过负载均衡器再生。假使T CP包的平均长度是536字节的话平均包再生延迟时间大约为60us 在P entium处理器上计算的采用更快的处理器将使得这个延迟时间变短负载均衡器的最大容许能力为8.93M/s假定每台物理服务器的平台容许能力为400K/s来计算负责均衡器能为22台物理服务器计算。

Virtual Server via NAT能够满足许多服务器的服务性能需求。即使是是负载均衡器成为整个系统的瓶颈如果是这样也有两种方法来解决它。一种是混合处理 另一种是采用Virtual Server via IP tunneling或Virtu al Server via direc t routing。如果采用混合处理的方法将需要许多同属单一的RR DNS域。你采用Virtual S erver via IP tunneling或Virtu al S erver viadirect routi ng 以获得更好的可扩展性。也可以嵌套使用负载均衡器 在最前端的是VS-Tunneling或VS-Drouting的负载均衡器然后后面采用VS-N AT的负载均衡器。

2.2.Virtual server via IP tunneling VS-TUN

采用VS-NAT方式请求与应答包都需要经过负载均衡器那么当服务器节点增长到20个或更多时这个负载均衡器就可能成为新的瓶颈。我们发现许多Internet服务例如WEB服务器的请求包很短小而应答包通常很大。

而使用VS-TUN方式的话负载均衡器只负责将请求包分发给物理服务器而物理服务器将应答包直接发给用户。所以负载均衡器能处理很巨大的请求量这种方式一台负

载均衡能为超过100台的物理服务器服务负载均衡器不再是系统的瓶颈。使用VS-TUN方式如果你的负载均衡器拥有100M的全双工网卡的话就能使得整个Virtual Server能达到1G的吞吐量。

IP tunneling IP隧道能够用于架构一个高性能的virtual s erver非常适合构建virtual proxys erver 因为当代理服务器收到了请求能够让最终用户直接与服务器联系。

但是这种方式需要所有的服务器支持IP Tunneling(IP Enc apsulat ion)协议我仅在Linux系统上实现了这个如果你能让其它操作系统支持还在探索之中。

2.3.Virtual Server via Direct Routing VS-DR

就象VS-TUN一下在VS-DR方式下负载均衡器也只是分发请求应答包通过单独的路由方法返回给客户端。这种方式能够大大提高Virtu al S erve r的可扩展性。与VS-TUN相比 VS-DR这种实现方式不需要隧道结构但它要求负载均衡器的网卡必须与物理网卡在一个物理段上。

而且VS-DR模式可以使用大多数操作系统做为物理服务器其中包括 Linux 2.0.36、

2.2.9、 2.2.10、 2.2.12 Solaris 2.5.1、 2.6、 2.7 FreeBSD 3.1、 3.2、 3.3 NT4.0无需打补丁IRIX 6.5 HPUX1 1等

3.安装配置LVS

LVS的安装配置主要可以分成以下三个步骤

1 下载LVS软件

2 安装、配置负载均衡器

3 安装、配置物理服务器

3.1.安装前的准备

1).下载LVS软件

大家可以到LVS 的主页 linuxvirtu als er ver.org">http://w ww.linux virtu als er ver.org<http://b lo g.c hinaunix.net/link.php?url=http://w w w.linuxvirtuals er ver.org%2 F>选择“S o ftwar e”链接选取最新版的补丁包tar包下载。这个包里包含了内核补丁和源程序。

2).安装的指导思想

如果你选用了VS-NAT模式的话则可以使用所有支持TCP/IP协议的操作系统构建的机器作物理服务器并且无须做任何修改。

如果你选用了VS-T UN模式的话则选择Li nux作物理服务器的操作系统并根据后面的介绍做相应的设置。

如果你选用了VS-DR模式的话则可以选择大多数操作系统如上节所述作物理服务器并根据后面的介绍做相应的设置。

3).各种操作系统作物理服务器的要点详解a Linux 2.0.36

这种操作系统无需做任何修改就可以运行在VS-N AT、VS-T un、VS-D R三种模式下。b Linux 2.2.x

无需任何修改就可运行VS-NAT模式。而使用VS-DR和VS-Tun两种模式可能会引起ARP问题。这种情况

就必须 ¨为2.2.x内核打补丁

· Stephen WillI ams的补丁包

你 可 以 在 http://www.linuxvirtu als erver.org/s dw_fullar pfix.patc h<http://blog.c hinaunix.net/link.php?url=http://w w w.linuxvirtuals er ver.org%2F s dw_fullarp fix.patch>获取它的原理十分简单让物理服务器不响应对虚拟IP的ARP请求。

· Julian Anast asov的补丁包

你 可 以 在 http://w w w.linuxvirtu als er ver.org/arp_invis ible-2213-2.diff<http://blog.c hinaunix.net/link.php?url=http://w w w.linuxvirtuals er ver.org%2F arp_invi s ible-2213-

2.diff>处获取然后用以下方法使其生效echo 1 /proc/sys/net/ipv4/c onf/interfac e_name/arp_invisi ble

¨新添一块网卡承载虚拟IP地址

你可以选择一块I SA网卡或廉价的PCI网卡来用于这个功能。你可以将这个接口的ARP功能关闭。

¨将物理服务器放置于与虚拟IP地址不同的网络上并且确认客户端无法直接路由到物理服务器所在网段。这种方法需要在负载均衡器上有两块网卡象防火墙一样工作。

¨在客户端或路由器将虚拟IP地址与负载均衡器的物理MAC地址绑定。

¨使用IPCHINA重写每一个进入的包将其从lo接口送入。c其它操作系统

如果是VS-NAT的话无需修改。如果是VS-DR的话需要采取一些相应的配置方法设置物理服务器的IP地址使其拥有LVS的虚拟IP地址。用其它操作系统的话不能使用VS-Tun方法。

4).准备硬件环境

构建服务器集群系统至少需要3台机器 1台用于负载均衡器 2台用于物理服务器。少于这个数字的话就没有意义了。

负载均衡器运行在打了补丁的2.2.x核心Li nux系统。

物理服务器

VS-NAT任何机器、任何操作系统运行Internet网络服务如HTTP、 FTP、 Telnet、SMTP、NNTP、 DNS等。

VS-TUN任何机器、支持IP隧道的操作系统迄今为止仅有Linu x

VS-DR任何机器、大多操作系统。

3.2.理解LVS的相关术语

1).ipvs admipvs adm是LV S的一个用户界面。在负载均衡器上编译、安装ipv s admipvsadm sets

2).调度算法

LVS的负载均衡器有以下几种调度规则

Round-robin简称rrw eighted Round-robin简称wrr每个新的连接被轮流指派到每个物理服务器。

Least-connected简称lcweighted Least-connected简称wlc每个新的连接被分配到负担最小的服务器。

Persistent client c onnection简称pc c 持续的客户端连接内核2.2.10版以后才支持。所有来自同一个IP的客户端将一直连接到同一个物理服务器。超时时间被设置为360秒。P cc是为http s和c ookie服务设置的。在这处调度规则下第一次连接后所有以后来自相同客户端的连接包括来自其它端口将会发送到相同的物理服务器。但这也会带来一个问题大约有25的Internet可能具有相同的IP地址AOL的

客户是通过位于美国弗吉尼亚洲的一台服务器连入Internet的这种情况下只要有一个AOL的客户连接到一个物理服务器上那么所有来自AOL的客户连接将都被连到这一台物理服务器上。这将多么可怕呀

3).Persistent port c onnection调度算法

在内核2.2.12版以后 pcc功能已从一个调度算法你可以选择不同的调度算法 rr、

wrr、 lc、wlc、 pcc演变成为了一个开关选项你可以让rr、 wrr、 lc、wlc具备pcc的属性。在设置时如果你没有选择调度算法时 ipvsadm将默认为wlc算法。

在Persistent port c onnection(ppc)算法下连接的指派是基于端口的例如来自相同终端的80端口与443端口的请求将被分配到不同的物理服务器上。

不幸的是如果你需要在的网站上采用c o oki e s时将出问题 因为http是使用80端口然而cookies需要使用443端口这种方法下很可能会出现cookies不正常的情况。

3.3.配置实例

1).例一 http s onlya在lvs_dr.conf文件写入

SERVI CE=t https ppc 192.168.1.1b Ipvs adm设置

IP Virtual Server version 0.9.4(size=4096)

Prot LocalAddress:Port Scheduler Flags

-RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP ssl.mack.net:https wlc persistent 360

-di.mack.net:https Route 1 00

2).例二All ports sticky超时为30分 wrr调度算法a在lvs_dr.conf文件写入

SERVI CE=t 0 wrr ppc -t 1800192.168.1.1

#ppc persistent connection, timeout 1800 sec

/sbin/ipvsadm-A-t 192.168.1.110:0-s wrr-p 1800echo adding service 0 to realserver 192.168.1.1 using connection

接上行 type dr weight 1\"

/sbin/ipvsadm-a-t 192.168.1.110:0-R 192.168.1.1 -g-w 1b Ipvs adm设置

#ipvs adm

IP Virtual Server version 0.9.4(size=4096)

Prot LocalAddress:Port Scheduler Flags

-RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP ssl.mack.net:https wrr persistent 1800

-di.mack.net:https Route 1 00

3.4.配置方法

1).准备

用配置脚本*.c onf作为输入产生rc.lvs脚本然后放置在/etc/init.d或/etc/rc.d目录下。

早期版本的配置脚本可以运行在任何机器上。然而现在的配置脚本针对不同的内核版本是有些不同的。你必须在负载均衡器上运行、检测内核版本。将在负载均衡器上的配置文件和目录通过nfs输出这个目录到物理服务器上以供配置需要。 必须先在负载均衡器上运行脚本rc.lvs然后在物理服务器上运行。

根据你选择的LVS工作模式VS-NAT、 VS-Tun、VS-DR选择适当的conf文件模板lvs_nat.conf、

lvs_tun.c onf、 lvs_dr.c onf然后根据实际情况修改IP地址与服务。在缺省状态下只配置了telnet服务。telnet服务能够很方便地用于测试当客户机telnet登录时根据提示符就可以知道登录到的是哪一台物理

服务器。

你可以编辑conf配置文件来增加其它的服务。在配置文件中提供了集群内部的IP地址建议值

192.168.1.x/24、 10.1.1.x/24。

在配置文件中你可以使用名称如telnet或端口 如23来标识服务。使用名称时要注意须与

/etc/s ervic es中匹配。 /etc/s ervic es文件内容如下所示ssh22/tcpdomain 53/tcp nameserver dns#the string dns needs to be added heredomain 53/tcp nameserver dns#and herehttp s 443/tc phttp s 443/udp

在多种情况下一台机器常需要多个IP地址你可以使用IP别名内核支持的可选项一般情况下已含在内核中来为一块网卡指定多个IP地址。

2).运行配置脚本

$ ./configure.pl lvs_nat.conf

这将产生一个rc.lvs脚本。稍后将rc.lvs_xxx放到/etc/rc.d或/etc/init.d中去将mon_xxx.c f放在/etc/mon目录下。

3).rc.lvs脚本选项a).为负载均衡器与物理服务器增加以太网设备和路由器b).使用fping检查连接c).运行ipchains VS-NAT方式d).激活ipforw arde).关闭I CMP重定向功能VS-D R和VS-T un方式f).增加ipv s adm服务。

4).继续

在物理服务器上运行

$ . ./rc.lvs_nat或

$sh rc.lvs_natrc.lvs脚本能够自动判断是运行在负载均衡器tests x/sbin/ipvsadm还是物理服务器上检查ifconfig。

检查ipvsadm、 ifconfig a和netstat rn的输出检查服务/IP地址是否正确。如果不正确的话请重

新编辑然后再运行一次。

3.5.测试LVS

检查每一台物理服务器上运行的服务看它们的IP是不是LVS的虚拟IP-VIP 使用netstat an。如果运行rc.lvs_xxx脚本没有出错的话你从客户端telnet到VIP 在本文中是192.168.1.110你将会登录到其中的一台物理服务器上并看到这台物理服务器的登录提示。

在负载均衡器上查看ipvs adm的输出你会在23端口上看到一个与物理服务器的连接。而在物理服务器上执行 $netstat -an|grep 23命令查看到相关信息。客户端lo gout退出后再次登录虚拟IP时你将会看到另一台物理服务器的登录提示符。

4 VS-NAT模式

VS-NAT是基于CISCO的负载均衡器 LocalDirec tor实现的。

4.1.安装VS-NAT

根据下表设置客户端、负载均衡器、物理服务器的IP地址

表21-2.客户端、负载均衡器、物理服务器的IP地址

机器IP地址

客户端192.168.1.254

负载均衡器的虚拟IP 192.168.1.110(LVS表现的IP)

负载均衡器内部网卡10.1.1.1

物理服务器1 10.1.1.2

物理服务器2 10.1.1.3

物理服务器3 10.1.1.4

…………

物理服务器n10.1.1.n+1

物理服务器的默认

网关10.1.1.1

对于VS-NAT方法来说物理服务器必须位于与客户机、 LVS的虚拟IP地址不同的网段上也就是说在物理服务器上不能直接PING通客户机。

由于负载均衡器有两个IP地址一个是LVS的虚拟IP地址另一个IP地址是内部地址--所有物理服务器默认网关。当数据包从物理服务器发送到负载均衡器时负载均衡器根据地址翻译N AT规则将包转发到客户端。 由于负载均衡器是一个地址翻译器所以I CMP的重定向功能失效 PING无法应用。可以采用IP别名的方法也可以使用双网卡方法来实现这个。

配置脚本将会配置IP伪装。 以下是在configure.pl脚本中的程序段echo turning on mas querading

#s etup mas queradingecho 1 /proc/sys/net/ipv4/ip_forwardecho installing ipchain rules

/sbin/ipchains -A forward-j MASQ-s 10.1.1.0/24-d 0.0.0.0/0echo ipchain rules

/sbin/ipchains L

所有与NAT有关的规则设置都在rc.lvs_nat文件中表现。

4.2.配置VS-NAT

在负载均衡器以及每一台物理服务器上分别执行rc.lvs_xxx脚本程序使用lvs_nat.conf这个模板来生成rc.lvs_nat配置文件。

VS-NAT将会对端口重新映射一个来自于80端口的请求负载均衡器会将其发给物理服务器的8000端口。 由于数据包的源地址和目标地址已经被重写所以无需对重新端口增加额外的开销。很低的重写数据包速度60us/包限制了VS-NAT的最大处理能力而且VS-NAT的最大处理能力不是与增加的物理服务器成正比的。

VS-NAT实现方法的最大优点是物理服务器可以是任何一种操作系统无需为了完成LVS而作任何修改而且可以实现一些在L inux上不存在服务。

4.33.VS-NAT与Linux核心支持的NAT

当然可以使用ip c hains或ip fw构建基于Li nux内核的N AT防火墙。而使用了基于2.0.36版内核的LVS补丁包后常规的内核模块如ip_mas q_ftp等不再工作而且不再需要装载。

5.VS-DR模式

5.1.总论

VS-DR是基于IBM的NetDispathc er实现的。NetDispatc her位于WEB服务器的前端对于客户端来说就象一台WEB服务器。NetDispatc her曾服务于奥运会、卡斯帕罗夫与深蓝电脑的国际象棋比赛。

这里有一个VS-DR的IP地址设置的实例。注意物理服务器与VIP位于同一个网络上。

VS-DR模式在以下几方面受到了限制

1 物理服务器和负载均衡器必须在同一个网段上它们之间必须能使用arp协议它们之间在数据链路层上传递数据包

2 客户端必须通过负载均衡器的VIP访问集群

3 物理服务器必须有到客户端的路由即使客户端没有到物理服务器的路由。因为从物理服务器返回到客户商的包将直接发送无须通过负载均衡器转发。

VS-DR模式下客户端通常与负载均衡器和物理服务器位于不同的网络中而且每一个物理服务器拥有自己对外的路由表。在下面这个简单的例子中所有的机器都在

192.168.1.0这个网络物理服务器不需要设置默认路。 网络拓扑结构如下图所示

IP分配如下表所示

表21-3.IP分配

机器IP地址

客户端本机IP CIP 192.168.1.254

负载均衡器本机IP DIP 192.168.1.1

虚拟IP VIP 192.168.1.110 ARP与客户端使用

物理服务器1本机IP RIP 192.168.1.2

虚拟IP VIP 192.168.1.110 不ARP

物理服务器2本机IP RIP 192.168.1.3

虚拟IP VIP 192.168.1.110 不ARP

物理服务器3本机IP RIP 192.168.1.4

虚拟IP VIP 192.168.1.110 不ARP

5.2.VS-DR良好的扩展性

VS-NAT方法受限于经过负载均衡器的每一包都必须重写用这种方法最大的数据吞吐量受限于负载均衡器的环境。 如一台P entium机器快速以太网最大的数据吞吐量为80M/秒而且增加物理服务器的数量并不能增加这个最大数据吞吐量。而使用VS-DR模式速度限制则在每个物理服务器与Internet连接的包处理能力而对负载均衡器的要求不大 因为其只需处理简单的包。在VS-DR的模式下能够增加更多物理服务器以提高系统能力。

6 VS-TUN模式

6.1.总论

VS-Tun是LVS独创的的它是基于VS-DR发展的。具有良好的可扩展性和服务吞吐量。

使用VS-T un方式的话必须采Li nux作为物理服务器而负载均衡器将I P请求重新包装成IPIP包后发给

物理服务器。所以物理服务器必须能够解I P IP包装才能现在只有Linux操作系统能处理IPIP包IP隧道技

术。

不同于VS-D R VS-T un方案允许物理服务器与负载均衡器在不同的网络上甚至允许所有的机器都在

单独的网络上那怕物理服务器位于不同的国家例如做一个项目的FTP站点镜像。

在这种情况下物理

服务器将产生源地址=虚拟IP地址 目标地址=客户机IP地址的IP包。

如果物理服务器与负载均衡器位于相同的网络上那么VS-D R和VS-T un是等价的。VS-DR更具有灵活

性 因为大多数操作系统都可以用来构建物理服务器。

6.2.VS-Tun实例

以下是一个VS-T un的IP配置实例。VS-T un提供的最大方便性就是不需要服务器与客户端位于同一个网络上仅需要客户端能寻径有路由到负载均衡器物理服务器能寻径有路由到客户机。 返回的包直接从物理服务器到客户端无须再经过负载均衡器

通常使用V S-T un模式时客户端是与负载均衡器、物理服务器位于不同网络上的而且每一台服务器

有一个通往外界的路由。

IP分配如下表所示

表21-4.IP分配

机器IP地址

客户端本机IP CIP 192.168.1.254

负载均衡器本机IP DIP 192.168.1.1

虚拟IP VIP 192.168.1.110 ARP与客户端使用

物理服务器1本机IP RIP 192.168.1.2

虚拟IP VIP 192.168.1.110 隧道技术不ARP

物理服务器2本机IP RIP 192.168.1.3

虚拟IP VIP 192.168.1.110 隧道技术不ARP

物理服务器3本机IP RIP 192.168.1.4

虚拟IP VIP 192.168.1.110 隧道技术不ARP

………………

物理服务器n本机IP RIP 192.168.1.n+1

虚拟IP VIP 192.168.1.110 隧道技术不ARP

6.3.配置VS-T un

1编辑配置文件模板lvs_tun.c onf后进行配置

$ ./configure_lvs.pl lvs_nat.conf

2在物理服务器上运行

$ . ./etc/rc.d/rc.lv s_tun

3将配置文件放到/etc/rc.d或/etc/init.d目录下。

4检查ipvsadm、 ifconfig a和netstat rn的输出检查服务/IP地址是否正确如果有误请修改后重新运行脚本。

-----------------------

用LVS实现多台服务器的负载均衡

Linux Virtu al S erve r简称LVS。是由中国一个Linu x程序员发起的开发项目计划其实现目标是创建一个具有良好的扩展性、高可靠性、高性能和高可用性的基于Lin ux系统的服务器集群使用LVS架设的服务器集群系统从体系结构上看是透明的最终用户只感觉到一个虚拟服务器物理服务器之间可以通过高速的LAN或分布在各地的WAN相连。最前端是负载均衡器它负责将各种服务请求分发给后面的物理服务器让整个集群表现得象一个服务于同一IP地址的虚拟服务器。

LVS集群系统具有良好的可扩展性和高可用性。可扩展性是指 LVS集群建立后可

以很容易地根据实际的需要增加或减少物理服务器。而高可用性是指当检测到服务器节点或服务进程出错、失效时集群系统能够自动进行适当的重新调整系统。

利用的技术可以很容易地构建 台邮件服务器的负载均衡器。

LVS是如何工作的

Linux Virtual Server的主要是在负载均衡器上实现的负载均衡器是一台加了LVS Patch的2.2.x版内核的Linux系统。 LVS Patch可以通过重新编译内核的方法加入内核也可以当作一个动态的模块插入现在的内核中。负载均衡器可以运行在以下三种模式下中的一种或几种

1Virtual Server via NAT VS-NAT用地址翻译实现虚拟服务器

2Virtual Server via IP Tunneling VS-TUN用IP隧道技术实现虚拟服务器

3Virtual Server via Direct Routing VS-DR用直接路由技术实现虚拟服务器。另外还需要根据LVS应用对物理服务器进行恰当的配置。

以下将分别讲述一下三种模式的工作原理和优缺点。

1.Virtual server via NAT VS-NAT

Virtual Serve r via NAT方法的最大优点是集群中的物理服务器可以使用任何支持T CP/IP操作系统物理服务器可以分配Internet的保留私有地址只有负载均衡器需要一个合法的IP地址。这种实现方法的最大的缺点是扩展性有限。当服务器节点普通PC服务器数据增长到20个或更多时负载均衡器将成为整个系统的瓶颈 因为所有的请求包和应答包都需要经过负载均衡器再生。假使T CP包的平均长度是536字节的话平均包再生延迟时间大约为60us 在P entium处理器上计算的采用更快的处理器将使得这个延迟时间变短负载均衡器的最大容许能力为8.93M/s假定每台物理服务器的平台容许能力为400K/s来计算负责均衡器能为22台物理服务器计算。Virtual Server via NAT能够满足许多服务器的服务性能需求。即使是是负载均衡器成为整个系统的瓶颈如果是这样也有两种方法来解决它。一种是混合处理另一种是采用Virtu al Server via IP tunne ling或Virtual Serve r viadirect routing。如果采用混合处理的方法将需要许多同属单一的RR DNS域。你采用VirtualServer via IP tunneling或Virtu al Server via direc t routing以获得更好的可扩展性。也可以嵌套使用负载均衡器在最前端的是VS-Tunneling或VS-Drouting的负载均衡器然后后面采用VS-NAT的负载均衡器。

2.Virtu al s erver via IP tunneling VS-TUN

采用VS-NAT方式请求与应答包都需要经过负载均衡器那么当服务器节点增长到20个或更多时这个负载均衡器就可能成为新的瓶颈。我们发现许多Internet服务例如WEB服务器的请求包很短小而应答包通常很大。而使用VS-T UN方式的话负载均衡器只负责将请求包分发给物理服务器而物理服务器将应答包直接发给用户。所以负载均衡器能处理很巨大的请求量这种方式一台负载均衡能为超过100台的物理服务器服务负载均衡器不再是系统的瓶颈。使用VS-TUN方式如果你的负载均衡器拥有100M的全双工网卡的话就能使得整个Virtual Server能达到1 G的吞吐量。

IP tunneling IP隧道能够用于架构一个高性能的virtual s erve r非常适合构建virtualproxy server因为当代理服务器收到了请求能够让最终用户直接与服务器联系。但是这种方式需要所有的服务器支持"IP Tunneling"(IP Encapsulation)协议我仅在Linux系统上实现了这个如果你能让其它操作系统支持还在探索之中。

3.Virtual Server via Direct Routing VS-DR

就象VS-TUN一下在VS-DR方式下负载均衡器也只是分发请求应答包通过单独的路由方法返回给客户端。这种方式能够大大提高Virtual Serve r的可扩展性。与VS-TUN相比 VS-DR这种实现方式不需要隧道结构但它要求负载均衡器的网卡必须与物理网卡

- 均衡器LinuxLVS集群服务器实施详解相关文档

- 服务器利用遗传算法的网络GIS集群服务器动态负载均衡算法

- 同步数据库集群系统设备清单 机型 技术参数 数量 数据库集群服务器 4U机 ....docx

- 服务器NC集群服务器使用详解

- 主管WEBLOGIC集群服务器主备机切换手册

- 集群SQL Server 2000集群服务器优缺点--.doc

- 可用性高可用ViSS存储代理集群服务器接入ViSS中心平台的实现

RackNerd 2022春节促销提供三款年付套餐 低至年付10.88美元

RackNerd 商家我们应该是比较熟悉的商家,速度一般,但是人家便宜且可选机房也是比较多的,较多集中在美国机房。包括前面的新年元旦促销的时候有提供年付10美元左右的方案,实际上RackNerd商家的营销策略也是如此,每逢节日都有活动,配置简单变化,价格基本差不多,所以我们网友看到没有必要囤货,有需要就选择。RackNerd 商家这次2022农历新年也是有几款年付套餐。低至RackNerd VPS...

易探云美国云服务器评测,主机低至33元/月,336元/年

美国服务器哪家平台好?美国服务器无需备案,即开即用,上线快。美国服务器多数带防御,且有时候项目运营的时候,防御能力是用户考虑的重点,特别是网站容易受到攻击的行业。现在有那么多美国一年服务器,哪家的美国云服务器好呢?美国服务器用哪家好?这里推荐易探云,有美国BGP、美国CN2、美国高防、美国GIA等云服务器,线路优化的不错。易探云刚好就是做香港及美国云服务器的主要商家之一,我们来看一下易探云美国云服...

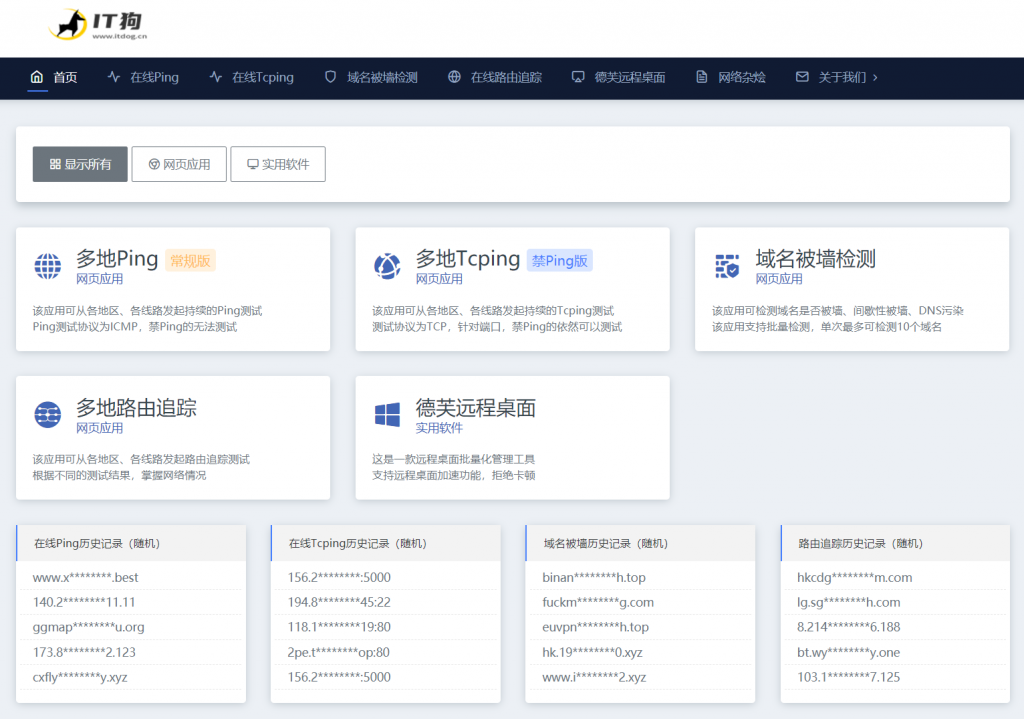

【IT狗】在线ping,在线tcping,路由追踪

IT狗为用户提供 在线ping、在线tcping、在线路由追踪、域名被墙检测、域名被污染检测 等实用工具。【工具地址】https://www.itdog.cn/【工具特色】1、目前同类网站中,在线ping 仅支持1次或少量次数的测试,无法客观的展现目标服务器一段时间的网络状况,IT狗Ping工具可持续的进行一段时间的ping测试,并生成更为直观的网络质量柱状图,让用户更容易掌握服务器在各地区、各线...

-

刷网站权重提升百度权重的几个方法人人时光机求徐智勇的时光机的歌词,百度上全是周杰轮跟五月天的,我要粤语啊在线漏洞检测如何查看网站的漏洞?网站运营网络运营主管的主要工作职责是什么?9flashIE9flash模块异常。开机滚动条开机滚动条要很长时间怎么解决?网页打开很慢为什么打开网页很慢网络广告投放网络广告投放有哪些技巧?qq等级表QQ等级天数表关闭qq相册图标怎样熄灭QQ相册图标