文件云存储

软件学报ISSN1000-9825,CODENRUXUEWE-mail:jos@iscas.

ac.

cnJournalofSoftware,2016,27(9):24002413[doi:10.

13328/j.

cnki.

jos.

004862]http://www.

jos.

org.

cn中国科学院软件研究所版权所有.

Tel:+86-10-62562563面向真实云存储环境的数据持有性证明系统肖达1,2,杨绿茵1,2,孙斌1,2,郑世慧1,21(北京邮电大学计算机学院,北京100876)2(灾备技术国家工程实验室(北京邮电大学),北京100876)通讯作者:肖达,E-mail:xiaoda99@bupt.

edu.

cn摘要:对数据动态更新和第三方审计的支持的实现方式是影响现有数据持有性证明(provabledatapossession,简称PDP)方案实用性的重要因素.

提出面向真实云存储环境的安全、高效的PDP系统IDPA-MF-PDP.

通过基于云存储数据更新模式的多文件持有性证明算法MF-PDP,显著减少审计多个文件的开销.

通过隐式第三方审计架构和显篡改审计日志,最大限度地减少了对用户在线的需求.

用户、云服务器和隐式审计者的三方交互协议,将MF-PDP和隐式第三方审计架构结合.

理论分析和实验结果表明:IDPA-MF-PDP具有与单文件PDP方案等同的安全性,且审计日志提供了可信的审计结果历史记录;IDPA-MF-PDP将持有性审计的计算和通信开销由与文件数线性相关减少到接近常数.

关键词:数据持有性检查;第三方审计;显篡改审计日志;存储安全;同态认证元中图法分类号:TP309中文引用格式:肖达,杨绿茵,孙斌,郑世慧.

面向真实云存储环境的数据持有性证明系统.

软件学报,2016,27(9):24002413.

http://www.

jos.

org.

cn/1000-9825/4862.

htm英文引用格式:XiaoD,YangLY,SunB,ZhengSH.

Provabledatapossessionsystemforrealisticcloudstorageenvironments.

RuanJianXueBao/JournalofSoftware,2016,27(9):24002413(inChinese).

http://www.

jos.

org.

cn/1000-9825/4862.

htmProvableDataPossessionSystemforRealisticCloudStorageEnvironmentsXIAODa1,2,YANGLü-Yin1,2,SUNBin1,2,ZHENGShi-Hui1,21(SchoolofComputerScience,BeijingUniversityofPostsandTelecommunications,Beijing100876,China)2(NationalEngineeringLaboratoryforDisasterBackupandRecovery(BeijingUniversityofPostsandTelecommunications),Beijing100876,China)Abstract:Themethodsforsupportingdynamicdataupdatesandthird-partyauditarekeyfactorsthataffectthepracticalityofexistingprovabledatapossession(PDP)schemes.

ThisarticleproposesasecureandefficientPDPsystemcalledIDPA-MF-PDPforrealisticcloudstorageenvironments.

Thecostofauditingmultiplefilesisdramaticallyreducedbyamultiple-filePDPschemebasedonthedataupdatepatternofcloudstorage.

Therequirementforusersbeingonlineisreducedtothemaximumextentbytheimplicitthird-partyauditframeworkandtamper-evidentauditlogs.

Thetripartiteinteractionprotocolbetweentheuser,thecloudserverandtheimplicitauditorcombinesMF-PDPwiththeimplicitthird-partyauditframework.

TheoreticalanalysisandexperimentalresultsshowthatIDPA-MF-PDPhasequivalentsecuritypropertywithsingle-filePDPschemesandtheauditlogprovidesatrustworthyhistoryrecordofauditresults;IDPA-MF-PDPreducesthecomputationandcommunicationoverheadofdatapossessionauditingfromlinearinthenumberoffilestonearconstant.

Keywords:provabledatapossession;third-partyaudit;tamper-evidentauditlog;storagesecurity;homomorphicauthenticator基金项目:国家自然科学基金(61202082);国家242信息安全计划(2014A120)Foundationitem:NationalNaturalScienceFoundationofChina(61202082)收稿时间:2014-05-07;修改时间:2014-12-31;采用时间:2015-05-15;jos在线出版时间:2015-09-01CNKI网络优先出版:2015-09-0116:00:47,http://www.

cnki.

net/kcms/detail/11.

2560.

TP.

20150901.

1600.

001.

html肖达等:面向真实云存储环境的数据持有性证明系统2401随着云存储的日益普及,如何保证存放在云端的用户数据的完整性,已成为云计算安全的一个重要问题[1].

数据持有性证明(provabledatapossession,简称PDP)方案[2]可以使用户远程检查存放在云存储服务器上数据的完整性,且无需将数据下载到本地.

虽然近年来已有众多PDP方案及其变种被提出[310],但这些理论方案距离在真实云存储环境中实际部署尚有距离.

有两个关键因素严重影响PDP方案的实用性.

首先,在云存储环境中,用户不但需要获取远程存储的数据,还应能对这些数据进行更新.

虽然研究者已提出支持动态更新操作的PDP方案[37],但它们都引入了复杂的数据结构,增加了方案的复杂度和审计开销;其次,为了减轻用户负担,现有PDP方案多借助独立于云存储服务提供商的机构作为可信第三方(trustedthirdparty,简称TTP)代替用户执行数据持有性检查[6,810].

这种架构增加了系统的部署和运营成本,不仅需使用支持公开验证的PDP方案[6],还引入了如何防止第三方窃取用户关键数据等新问题.

关于如何实现和部署TTP以及如何将审计结果以可信的方式提供给用户,现有研究均未给出具体可行的方案.

本文针对动态数据更新和基于TTP的PDP的实现和部署方式这两个问题给出了切实可行的解决方法,在此基础上,提出面向真实云存储环境的PDP系统IDPA-MF-PDP,为PDP从理论到实用迈出了一步.

具体来说:1)针对动态数据更新问题,我们观察到,云存储有别于传统存储(如文件系统)的数据更新模式,即:典型的数据更新操作不是对文件内容的插入或修改,而是静态文件数量的变化(通常为增加).

针对这种模式,我们定义了新的PDP方案——多文件数据持有性证明(multiple-fileprovabledatapossession,简称MF-PDP).

与原始PDP方案不同,MF-PDP在一次挑战中检查由数目可变的静态文件组成的文件组的完整性,以显著减少审计开销.

在现有单文件PDP方案的基础上,通过将同态认证元与数据块虚拟下标结合,构造一个安全高效的MF-PDP方案;2)针对真实云存储环境中TTP难以实现或部署的问题,我们提出基于隐式TTP的数据持有性审计架构,利用与云服务器集成在一起的防篡改可信硬件作为隐式数据持有性审计者(IDPA)执行TTP职能.

通过云服务器和隐式第三方的交互,生成可以被任何一方验证的显篡改审计日志,最大限度地降低对用户在线时间的需求,用户可以随时通过查看日志,以离线的方式审计云端数据的完整性.

这种实现方式有效地降低了TTP的部署和运营成本,且由于TTP是部署在云端的可信硬件,避免了第三方审计者窃取用户隐私数据的问题;3)为了将MF-PDP与隐式TTP审计架构集成,我们提出用户、云服务器和隐式第三方间的三方交互协议.

在交互中完成MF-PDP的挑战-应答过程以及审计结果的可信生成和保存,形成完整的IDPA-MF-PDP系统.

理论分析和实验结果表明:IDPA-MF-PDP具有和单文件PDP方案等同的安全性,且审计日志提供了可信的的审计历史记录;IDPA-MF-PDP将持有性审计的计算和通信开销由线性减少到接近常数水平,其性能主要受限于硬盘I/O能力,而非密码运算.

1多文件数据持有性证明1.

1数据更新模型我们观察到,云存储中的数据更新模型与传统存储系统不同:在传统文件系统中,文件内容常被读写、修改或删除;但是在云存储中,文件对象一旦被写入云中就会保持相对静态,即,用户很少修改、新增或者删除文件本身的内容.

在云存储的两个主要应用——备份和归档中,写入云中的数据,如文件系统的快照或者归档的对象,本身就是静态的.

云存储中数据更新的另一个特点是:删除操作比较少发生,并且通常以一组文件为单位发生(例如,一个到期归档对应的一组对象).

基于以上观察,我们提出了一个适用于云存储的数据更新模型:将一个由多个文件组成的文件组作为数据更新的基本单元.

向文件组中增加新的文件,即为文件组的更新操作.

文件被添加到文件组后,就不能再被修改或者从文件组中删除.

删除操作以文件组为单位进行,一个文件组中的所有文件被当作整体一并删除.

在该模型2402JournalofSoftware软件学报Vol.

27,No.

9,September2016基础上,我们提出MF-PDP方案.

下面对该云存储数据更新模型的提出依据和成立范围做进一步说明:首先,从统计数据上,欧盟统计局提供的2014年个人使用云存储情况调查报告[11]中统计了使用云存储服务存储各种文件类型的人口百分比.

静态文件(照片、音乐、视频)对应的人口百分比之和(144%)显著高于动态文件(文档、电子表格、演示文稿)对应的人口百分比之和(54%).

考虑到普通个人用户产生的上述静态文件的大小一般都大于上述动态文件,可以估计如果按照文件总大小统计,云存储中的静态文件的比例会更高.

其次,从云存储自身的定义上,狭义的云存储特指底层云存储服务,如AmazonS3,GoogleCloudStorage,MicrosoftAzureBlobstorage等;而广义的云存储还包括面向终端用户的在线文件备份同步和笔记类服务,如Dropbox、Mozy、金山快盘、印象笔记等.

虽然后者提供文件修改操作接口,但前者一般只提供不可变对象操作接口,即,只允许对一个完整的对象通过网络响应进行读、写、删除操作.

主流云存储服务AmazonS3和GoogleCloudStorage提供的都是这种接口.

本文的数据持有性证明方案主要针对这种底层云存储服务,作为基础安全设施.

因此,采用该数据更新模型是合理的.

值得指出的是:面向终端用户的在线文件备份服务可构建在云存储服务之上,并可将文件修改操作转化为不可变对象的添加.

例如,主流在线文件同步服务提供商Dropbox就是用AmazonS3作为其后端存储,并用二进制差量比对算法librsync[12]将文件更新转化为新文件相对旧文件的增量块存储在S3上.

开源在线备份工具Tarsnap[13]采用类似的做法.

学术界以云存储服务作为后端存储的文件系统,如Cumulus[14]和BlueSky[15]等,对外提供符合POSIX语义的标准文件系统接口,但在内部将文件切分为定长或可变长的分块作为不可变对象保存到AmazonS3中,以实现重复数据删除.

在这些应用场景中,数据更新模型中所指的文件组中的"文件"并不是一般意义上的文件,而是文件拆分后形成的不可变对象(数据块).

1.

2MF-PDP方案MF-PDP模型包含5种多项式时间算法.

KenGen()→(pk,sk)是一个密钥生成算法.

用户和验证端DPA都可用此算法生成公私钥对,自己保存私钥,并把公钥分发给其他两方.

我们用upk,usk表示用户公私钥对,用dpk,dsk表示DPA公私钥对;Add(usk,F,α,GID)→(F′,M,α′)是一个向文件组添加文件的算法,由用户运行.

算法将文件F分块,每块长度为L位,为每个文件块生成认证元数据,并更新持久状态α(α为验证端为每个文件组维护的持久状态).

输出为文件块集合F′,认证元数据M,及更改后的持久状态α′;Challenge(α)→chal是为当前文件组生成挑战的算法,由验证端运行.

算法以该文件组持久状态α为输入;Prove(upk,chal,F′,M,α)→P由服务器端运行,为挑战生成相应的证据.

算法以用户公钥upk、挑战chal、一组文件块F′这些文件块对应的认证元数据M及文件组α为输入,输出证据P;Verify(upk,chal,P,α)→{0,1}是由验证端运行验证证据P的算法.

以用户公钥upk、挑战chal、证据P和持久状态α为输入.

如果验证通过输出"1",否则输出"0".

上述算法和文献[2]中PDP模型算法的主要区别为:(1)增加了向文件组添加文件的Add算法;(2)算法Challenge,Prove和Verify针对一个文件组而非一个文件.

一个原始的MF-PDP方案可以通过对文件组中每个文件使用某种单文件PDP方案(如文献[2])来实现,显然,该方案的复杂度为O(n),其中,n为文件组中文件的个数.

下面给出我们在文献[16]中提出的一个通过集成挑战来实现的更加高效的MF-PDP方案,其基本思想是:将这个文件组虚拟成为一个文件,将向文件组中添加文件的操作看作对虚拟文件的追加.

这样,对这个虚拟文件的一次挑战就可以检查这个文件组中的所有文件.

在这个虚拟文件中,每个文件块都有一个虚拟下标用作标识,这些下标也被用来生成同态认证元(homomorphicauthenticators).

需要指出:运行于底层云存储层的MF-PDP只是提供了文件分组机制,具体的文件分组策略需要由使用云肖达等:面向真实云存储环境的数据持有性证明系统2403存储服务的上层应用根据应用需求确定,使组内文件具有逻辑上的相关性,以方便文件管理.

例如:在法规遵从应用中,可将需要保存相同年限的文件分为一组;在归档应用中,可将同一文件系统卷在不同时间点的归档切分后形成的数据块分为一组;在照片备份应用中,可将用户在某一时期的照片文件分为一组.

由于在文件总数一定的条件下,持有性检查的计算开销和DPA的存储开销都和文件组个数成正比,因此在满足应用需求的前提下,应尽量减少文件组的个数,即,使每个文件组内包含尽量多的文件.

图1给出MF-PDP方案的算法描述.

MF-PDP的运行过程与基于随机抽样的单文件PDP[2]相似:在挑战阶段,验证端DPA向云存储服务器SSP发起挑战,验证通过虚拟下标标识的c个文件块的持有性,c个下标随机分布在文件组的所有文件中;SSP向DPA返回这c个块和其认证元的聚合值,DPA对这两个值进行验证.

算法用到3个密码学原语:哈希函数H、伪随机函数(PRF)e和伪随机置乱函数簇(PRP)π[T],分别用于生成同态认证元、聚合数据块和认证元的线性系数和抽查数据块的虚拟下标.

文件组持久状态α中包含当前文件组的大小(用B表示),在文件组创建过程中被初始化为0.

关于该方案算法的更详细说明见文献[16].

Fig.

1AlgorithmsofMF-PDPscheme图1MF-PDP方案算法2隐式可信第三方审计架构2.

1安全模型和架构基于隐式TTP的数据持有性审计架构的安全模型中存在3个角色,即云存储服务提供者(servicestorageprovider,简称SSP)、用户(user)、隐式数据持有性审计者(datapossessionauditor,简称DPA).

SSP是模型中唯一KenGen()→(pk,sk)1.

生成公钥pk=(N,e,g)和私钥sk=(N,d,g).

2.

输出(pk,sk).

Add(usk,F,α,GID)→(F′,M,α′)1.

令(N,d,g)=usk,(B)=α.

2.

将文件F分割成t个数据块,F[1],…,F[t],每个数据块的长度为L位.

3.

对于1≤i≤t:a)计算数据块F[i]的同态认证标签:A[i]=((H(GID)||B+i)gF[i])dmodN.

4.

记录F在文件组中的下标范围R=(B,B+t).

5.

更新文件组最大下标B′=B+t.

6.

输出(F′=F,M=(A[1],…,A[t],R),α′=(B′)).

Challenge(α)→chal1.

生成随机挑战密钥k1和k2:12{0,1},{0,1}RRkkκκ←←.

2.

根据目标安全等级定义将要挑战的数据块的数量c.

3.

输出chal=(c,k1,k2).

Prove(upk,chal,F′,M,α)→P1.

令(N,e,g)=upk,(c,k1,k2)=chal,(B)=α2.

对于1≤j≤c:a)计算要检测的数据块的虚拟下标值:1[]()jkiBjπ=;b)计算系数:2()jkbej=;c)定位要检测的数据块及它们的同态认证元:jjjjjjfiFiFiFRstartaiMAiMAiFRstart3.

计算11modcbbcaaiaiN=,这个值应与1111modcccbbfibfibdcHGIDiHGIDigN++相等.

4.

计算f=b1f[i1]+…+bcf[ic].

5.

输出P=(a,f).

Verify(upk,chal,P,α)→{0,1}1.

令(N,e,g)=upk,(c,k1,k2)=chal,(a,f)=P,(B)=α.

2.

对于1≤j≤c:a)计算1[]()jkiBjπ=和2()jkbej=3.

计算τ1=aemodN,121mod.

cbbfcHGIDiHGIDigNτ=4.

如果τ1=τ2则输出1,否则输出0.

2404JournalofSoftware软件学报Vol.

27,No.

9,September2016的威胁来源,有可能违反服务合同而未能完全履行保持用户数据完整性与持有性的责任.

DPA作为TTP能和SSP协同完成数据持有性审计而不受他方干扰,不与他方合谋,用户只信任由DPA生成的审计结果.

由于用独立于SSP的机构作为TTP存在难于实现和部署、潜在隐私数据泄露等问题,在我们的审计架构中,隐式DPA与云服务器集成在一起,并周期性地与SSP交互完成数据持有性审计,生成显篡改审计日志.

关于某个文件组的所有日志形成日志链表存放在云端,DPA对审计日志和链表进行签名认证,任何一方都能验证日志及链表的完整性和正确性,实现公开审计.

用户在多数时间里可以离线,而只在需要时查看并验证日志来获知数据的完整性.

用户、SSP和DPA的交互过程如图2所示(步骤1和步骤2也需要SSP和DPA交互,为清晰起见,在图中未画出;步骤2和步骤3.

1~步骤3.

3的审计交互过程在一个文件组的生命周期中均可多次执行且可交错进行).

需要指出:与传统TTP审计不同,隐式DPA为被动响应方,每次持有性审计请求由SSP发起,且DPA生成的审计结果由SSP保存.

这样最大限度降低了DPA的处理和存储需求,使基于可信硬件的实现成为可能.

隐式TTP审计架构有效降低了TTP的部署和运营成本,避免了审计者窃取用户隐私数据的问题.

2.

2DPA的实现我们提出用具有下列特性的防篡改(tamper-resistant)可信硬件实现隐式DPA:其他实体不能更改其内部程序和状态,不能获取其密钥信息;当检测到针对自己的物理攻击时,DPA应能对秘密信息执行自我销毁.

现有的安全协处理器产品如IBM4764[17],可以满足DPA的上述功能要求.

由于DPA部署在云端,SSP应保证DPA的正常工作,不受到来自外界的攻击.

因此,不论是因DPA自我销毁还是用户数据被损坏造成的日志链表不完整,都判定为SSP没有履行相关职责.

在实际云存储环境中,文件组数随用户数增加而增加.

由于SSP以文件组为单位与DPA进行交互,当文件组数量增加时,一个DPA可能无力负担.

此时,可采用多DPA协同工作的模式,以减轻单个DPA工作负担,提高系统可扩展性.

持有性审计由分布在SSP内网中多台服务器上多个DPA组成的集群共同完成,每个DPA负责系统中一部分用户所拥有的文件组的持有性审计,各DPA独立工作,并使DPA的数量随文件组的增加而增加.

IDPA-MF-PDP方案中,DPA的内部状态和执行功能的简单性,保证了上述多DPA集群方案的可行性.

多DPA的任务调度方法和协同工作协议不在本文的讨论范畴.

2.

3显篡改审计日志审计日志由DPA根据数据持有性检查结果生成,是存储在磁盘介质上的结构化记录(图3).

日志项(logentry,简称LE)是根据持有性检查结果生成的一个日志项,对应于同一个文件组的所有日志项将形成一个日志链表.

用户通过调阅文件的日志链表,即可查看该文件组的持有性审计历史.

LE由5个字段组成,其中,result是本次持有性检查的结果,结果为1表示文件完好,结果为0表示文件受损;time为日志生成的时间,用于保证日志项的新鲜性和不可复制性;eid是日志项在云中的唯一标识;prev_eid为同一文件前一次审计对应的日志项标识,用于形成日志链表;sig是DPA利用其私钥dsk对result,time,eid和prev_eid一起的RSA签名.

项引用(entryreference,简称ER)唯一地对应于一个文件组,由5个字段构成,其中,UID为用户的身份标识,GID为该文件组的标识,二者在云中是唯一的;eid是一个日志项标识;time是ER被创建或修改的时间戳;sig是DPA利用其私钥dsk对前4个字段的RSA签名.

ER总是与该文件组的最新一次持有性审计产生的日志项LEUserSSPDPA1.

创建文件组2.

添加文件显篡改日志4.

3.

3验证并生成日志项Fig.

2Reciprocalprocesswithimplicitthirdparty图2隐式第三方审计架构的三方交互过程肖达等:面向真实云存储环境的数据持有性证明系统2405具有相同的eid.

当文件组被创建后,DPA生成一个与之对应的ER.

没有审计过的文件组,即没有对应的日志项,其ER.

eid为1,且ER.

sig为空.

Fig.

3Loglistofonefilegroup图3一个文件组的审计日志链3三方交互协议为了将MF-PDP与隐式第三方审计架构整合,本节就创建文件组、向文件组添加文件、删除文件组和审计这4个操作给出用户、DPA与SSP之间的交互协议.

该协议中同时包含了MF-PDP的挑战-应答过程以及审计结果的可信生成和保存过程,形成完整的基于隐式DPA的多文件数据持有性证明系统(implicitDPAmultiple-filePDP,简称IDPA-MF-PDP).

协议的设计原则是:在保证安全性的前提下,尽可能降低对DPA的计算和存储需求.

下述各协议中假设各方均能获得他方的公钥.

3.

1创建文件组交互协议图4描述了创建文件组的交互过程.

假设在协议开始前,DPA存有所有用户的UID,且UID在DPA和云中都是唯一的.

DPA为每个用户创建的每个文件组维护一个持久状态,保存在α中.

Fig.

4Interactionprotocolofcreatingfilegroup图4创建文件组交互协议当用户需要创建文件组时,向SSP发送创建文件组的请求.

SSP接到请求后,将这个请求连同用户UID传递给DPA.

DPA接到请求,完成图4中所示工作,并为这个文件组生成一个项引用ER,置ER.

time与ER.

sig为空,USER→SSP:CREATE_GROUIP_REQUEST()SSP→DPA:CREATE_GROUIP_REQUEST(UID)DPA:VERIFY_ID(UID)GID←UUID()α[UID,GID]←0ER.

uid←UIDER.

gid←GIDER.

time←NULLER.

eid←1ER.

sig←NULLsigned_msg←SIGN_MSGdsk(GID,α[UID,GID])DPA→SSP:signed_msgERSSP:write(UID,GID,α,ER)SSP→USER:signed_msgUSER:(GID,α)←VERIFY_MSGdpk(signed_msg)write(GID,α)resulttimeeid0prev_eidsigresulttimeeid1prev_eidsigresulttimeeid2prev_eidsigUIDGIDeid2timesigLE0LE1LE2ER2406JournalofSoftware软件学报Vol.

27,No.

9,September2016ER.

eid为1,表示该文件组尚未被审计.

DPA用自己的私钥dsk为GID和α生成签名消息signed_msg,并将其与ER返回给SSP,SSP从signed_msg中用提取出的GID与α,将其与ER保存,并将signed_msg返回给用户.

用户需本地保存GID和状态α.

3.

2添加文件交互协议图5描述了向文件组添加文件的交互过程.

用户调用MF-PDP.

Add(usk,F,α,GID)→(F′,M,α′),将文件F分为t块,为每个文件块生成同态认证元,并更新本地该文件组的持久状态α.

用户将文件块集合F′、同态认证元集合M、块数t以及目标组GID发送给SSP,请求向文件组添加文件.

SSP将UID,GID及t发送给DPA.

DPA接到请求,完成图5所示的工作,最终将修改后的文件组信息生成签名消息返回给SSP.

SSP接到签名消息后,对F′,M和α进行存储,并将签名消息返回给用户进行比对.

Fig.

5Interactionprotocolofaddingafiletoafilegroup图5添加文件交互协议3.

3删除文件组交互协议图6列出了DPA与SSP交互完成删除文件组操作的过程.

Fig.

6Interactionprotocolofdeletingafilegroup图6删除文件组交互协议用户向SSP发起删除文件组的请求,SSP将这个请求传递给DPA,DPA将自身存储的该文件组的记录删除.

删除成功后,将GID及删除标识生成签名消息返回给SSP.

SSP将该组的文件块、认证元及其他信息全部删除,USER:MF-PDP.

Add(usk,F,α,GID)→(F′,M,α′)USER→SSP:ADD_REQUEST(F′,M,t,GID)SSP→DPA:(UID,GID,t)DPA:VERIFY_ID(UID,GID)B=α[UID,GID]α[UID,GID]=B+tsigned_msg←SIGN_MSGdsk(GID,α[UID,GID])DPA→SSP:signed_msgSSP:write(F′,M,α′)SSP→USER:signed_msgUSER:(GID,α)←VERIFY_MSG(signed_msg)check(GID,α)USER→SSP:DELETE_REQUEST(GID)SSP→DPA:GROUIP_DELETE_REQUEST(UID,GID)DPA:VERIFY_ID(UID,GID)DELETE(UID,GID)signed_msg←SIGN_MSGdsk(GID,DELETED)DPA→SSP:signed_msgSSP:DELETE_GROUIP(GID)SSP→USER:signed_msgUSER:(GID,DELETED)←VERIFY_MSG(signed_msg)check(GID,DELETED)肖达等:面向真实云存储环境的数据持有性证明系统2407并向用户返回签名消息.

3.

4审计交互协议图7描述了SSP与DPA交互完成文件组审计的过程(SIGNk(M)函数用私钥k计算消息M的签名).

SSP以文件组为单位,周期性地向DPA发送DPC请求,每个周期用epoch表示.

DPA收到审计请求后,以该文件组的持久状态α为参数,向SSP发起挑战.

SSP根据收到的挑战计算证据P,并将其连同该文件组的ER一起发送给DPA.

DPA收到证据和ER后,验证ER的新鲜性和真伪(通过time和sig域),验证通过,则生成新的日志项LE,将对证据的验证结果写入其中,并更新ER的time和sig域.

若此文件为第1次接受审计,由图4中创建文件组交互协议可知:此时,ER.

eid为NULL,因此对应于第1次审计结果的日志项LE.

prev_id为NULL.

最终,DPA将LE连同ER返回给SSP,由其写入审计日志.

Fig.

7Interactionprotocolofauditing图7审计过程交互协议4性能与安全性分析4.

1开销复杂度分析我们从I/O开销、计算开销、通信开销和DPA存储开销这4个方面来分析IDPA-MF-PDP的性能.

服务器端的磁盘I/O开销由读取挑战指定的c个抽样块带来.

根据文献[16]中的分析,为了以一定的置信度检测一定比例的块损坏发生,所需抽样块个数c为常数,与文件组内文件个数n无关.

计算开销主要由指数运算引起.

在IDPA-MF-PDP方案中:服务器在Prove阶段需要计算11modcbbcaaiaiN=,其中包含c次指数运算;DPA在Verify阶段需要计算τ1=aemodN和121mod,cbbfcHGIDiHGIDigNτ=其中包含了c+2次指数运算;DPA在生成日志时需要验证服务器提供的ER的签名,并生成新的ER和LE的签名,其中包含3次指数运算.

通信开销由Challenge阶段在服务器和DPA之间传递的比特数决定.

DPA向服务器端发送挑战chal=(c,k1,k2),这个挑战的长度为log2Tmax+2κ比特.

服务器端向DPA返回验证结果P=(a,f),长度为L′+log2N比特(其中,L′是f=b1f[i1]+…+bcf[ic]的长度,仅比文件块的长度L略长).

DPA存储开销取决于密钥和持久状态的大小.

在IDPA-MF-PDP方案中:DPA存储生成和验证同态认证元的SSP→DPA:AUDIT_REQUEST(UID,GID)DPA:VERIFY_ID(UID,GID)chal←MF-PDP.

Challenge(α[UID,GID])DPA→SSP:chalSSP:MF-PDP.

Prove(upk,chal,F′,M,α)→PSSP→DPA:(P,ER)DPA:VERIFY_ER(ER.

time,ER.

sig)result←MF-PDP.

Verify(pk,chal,P,α[UID,GID])LE.

result←resultLE.

time←GET_CUR_TIME()LE.

eid←GET_EID()LE.

prev_eid←ER.

eidLE.

sig←SIGN(LE.

result,LE.

time,LE.

eid,LE.

prev_eid)ER.

eid←LE.

eidER.

time←LE.

timeER.

sig←SIGN(ER.

uid,ER.

gid,ER.

eid,ER.

time)DPA→SSP:(ER,LE)SSP:write(ER,LE)2408JournalofSoftware软件学报Vol.

27,No.

9,September2016RSA密钥对(n,e,d),大小为2log2N比特;日志项的签名密钥对,大小为2log2N比特;持久状态α=(B),大小为mlog2Tmax比特(其中,m为此DPA管理的文件组个数).

为了比较IDPA-MF-PDP的性能,我们引入了两个基本的MF-PDP方案作为比较基准,其中,PDP方案用文献[2]中的方案分别为文件组中每个文件做数据持有性检查;DPDP方案以文献[4]中第3.

2节的方案为基础,用一个多层级跳跃表(skiplist)维护文件组中所有文件.

DPDP以文件为单位,将文件块的tag值作为叶子节点计算一个跳跃表,并将文件组中每个文件跳跃表的起始节点(startnode)作为叶子节点构造父级跳跃表.

假设文件组中有n个文件,且这些文件中单个文件块数最大值为Tmax,则文件组跳跃表高度为logn+logTmax.

在Prove阶段,DPDP返回c个抽样块的tag值和文件块聚合值M及这些块在跳跃表中的验证路径(verificationpath);Verify阶段,首先根据DPA本地保存的文件组起始节点验证c个tag值及其返回路径,再做c个tag的乘法聚合值,将其与M做比较.

3个方案均基于本文提出的由DPA担任隐式第三方的审计架构.

表1总结了IDPA-MF-PDP的复杂度和开销构成,并且将其与DPDP和PDP方案做出比较.

从表中可以得出:IDPA-MF-PDP将所有开销均减小到O(1),其中,DPA计算开销和存储开销的大幅降低使基于可信硬件的DPA得以实现.

需要特别指出:DPDP方案的服务器计算开销虽然不包含指数运算,在表中表示为O(1),但其需为每个挑战块利用哈希计算验证路径,耗时为O(logn).

Table1ComplexityofPDP,DPDPandIDPA-MF-PDP表1PDP,DPDP和IDPA-MF-PDP审计交互的开销复杂度与构成方案服务器I/O(抽样块个数)服务器计算开销(指数运算次数)DPA计算开销(指数运算次数)服务器与DPA间通信开销(比特)DPA存储开销(比特)PDP复杂度O(n)O(n)O(n)O(n)O(n)DPDP复杂度O(1)O(1)O(1)O(logn)O(1)IDPA-MF-PDP复杂度O(1)O(1)O(1)O(1)O(1)IDPA-MF-PDP开销构成ccc+5log2Tmax+2κ+L′+log2N+2|ER|+|LE|4log2N+log2Tmax说明:n为文件组中文件的个数(在审计交互协议中,服务器端向DPA返回响应时,一并将文件组的项引用ER返回给DPA,其大小为|ER|.

DPA生成日志,并将其返回给服务器存储时,也会产生常数级的通信开销,包括新的项引用ER新生成日志项LE,其大小为|ER|+|LE|).

4.

2安全性分析我们通过4个定理将IDPA-MF-PDP的数据持有性审计过程分解为结果的生成(定理1、定理2)和结果的保存(定理3、定理4)两个环节论证其安全性.

我们假设在IDPA-MF-PDP架构中DPA是可信的,即,外界不能修改DPA用于生成日志的时钟、密钥、程序等内部状态和数据(见第2.

2节).

定理1.

在DPA持有正确的文件组持久状态的前提下,MF-PDP具有和基本PDP方案[2]等同的安全性.

证明:在MF-PDP中,我们把文件组作为数据持有性审计的单元.

文件组中包含不定数目的文件,每个文件都被分成特定长度的数据块,每个数据块都被赋予一个在文件组中的虚拟下标.

在Prove阶段,SSP先根据文件组持久状态为挑战生成一组在文件组中的虚拟下标,然后,通过这组虚拟下标生成同态认证元,计算需要返回的证据P.

同样,在Verify阶段,DPA也需先计算出挑战块的虚拟下标,再将自己计算的验证值与SSP返回的证据P相比较(见第1.

2节).

这样,一个文件组就可以被看作一个虚拟的大文件,对文件组中任意文件数据块的损坏等价于对虚拟文件数据块的损坏,对文件组内所有文件的审计就归约为对这个虚拟文件的审计,MF-PDP的安全性就可以规约为单文件数据持有性的安全性.

而在文献[2]中,Ateniese等人已给出严格的单文件PDP的安全性证明,本文将不再赘述(关于MF-PDP安全性更详尽的分析,参见文献[16]).

定理2.

在一个文件组的由正常操作组成的生命周期内,DPA始终持有正确的该文件组持久状态.

证明:在IDPA-MF-PDP中,DPA为每个文件组保持一个持久状态,作为生成挑战的依据.

由于DPA是可信的,外界只能通过SSP和DPA间的交互协议.

在创建文件组时,DPA将文件组的α初始化为0,保证其初始状态的正确性(第3.

1节).

在向文件组添加文件时,用户与DPA都将自身存储的α值进行修改,其中,用户修改后的α值一定肖达等:面向真实云存储环境的数据持有性证明系统2409是正确的.

DPA将修改后的α值用自己的私钥进行签名,传递给用户进行比对.

用户用DPA的公钥对签名消息进行验证并提取出签名消息中的α与自身的α进行比对,如果结果一致,则DPA中现有的α也是正确的(第3.

2节).

因此,只要文件组的创建过程以及向文件组添加文件的过程正确执行,则DPA中保存的α一直是正确的.

定理1和定理2保证了每次数据持有性审计生成结果的可信性.

为了给出关于记录审计结果的审计历史的可信性的定理3和定理4,下面先给出3个相关定义.

定义1(项引用ER的可验证性).

称项引用ER是可验证的,当且仅当:(1)用DPA的公钥dpk可验证ER.

sig;(2)ER.

time落在距离当前时刻最近的epoch内.

定义2(日志项LE的可验证性).

称日志项LE是可验证的,当且仅当用DPA公钥dpk可验证LE.

sig.

定义3(审计历史的一致性).

称文件组G的审计历史h处于一致状态,当且仅当:(1)项引用ER是可验证的;(2)ER.

eid指向的日志项LE存在且可验证;(3)对于日志链表中每一日志项LE,若LE.

prev_id不为空,其指向的LE存在且可验证.

定理3.

当SSP正确按照第3.

4节的交互协议与DPA进行交互时,所生成的关于文件组G的审计历史h一定处于一致状态.

证明:根据第3.

4节中的审计过程交互协议,当DPA收到来自SSP的响应P及当前文件组的项引用ER时,会先验证ER.

sig的正确性和ER.

time的新鲜性,验证通过后方可继续执行.

DPA周期性地发起挑战,在每个epoch内至少发生一次ER的更新,只要ER.

time落在最近的epoch内,则此ER确实为在最新一次审计过程中修改过的ER.

DPA生成用其私钥签名的保存本次审计结果的LE,并生成新的ER使其eid指向LE.

根据定义1~定义3易知:若SSP正确按照交互协议与DPA进行交互,得到的审计历史h一定处于一致状态.

用户可按照如下过程验证某个文件组G的审计历史h的一致状态:向SSP发送文件组GID,SSP根据用户请求返回该文件组的日志链表l;用户接收到l后首先验证ER,接着逐项验证链表中日志项LE,直至最后一个可验证的LE的prev_id域为空为止.

定理4.

文件组G的审计历史h在某个epoch内处于一致状态s1,则在h达到下一个epoch内的一致状态s2之前,任何针对h一致性的攻击(修改或丢弃)都无法在DPA与SSP审计交互过程中通过交互协议,或者无法在用户审查h时正确通过用户审计,而使h仍处于一致状态.

证明:假设h在一致状态s1时的索引项为ER1,敌手在h到达下一个一致状态s2前试图对其篡改.

下面分3种情况讨论:(1)如果敌手试图修改ER1,由于敌手无法掌握DPA的私钥,则其不能伪造ER.

sig,所以其对ER的任何字段的修改将违背定义3的条件(1),使审计历史h偏离一致状态;(2)如果审计日志链表不空且敌手试图修改或丢弃第一个LE,将违背定义3的条件(2),h偏离一致状态;(3)假设审计日志链表日志项个数大于1且敌手试图修改或丢弃除第一个LE外的其他LE,将违背定义3的条件(3),h偏离一致状态.

由以上分析可知:对审计历史h的任何部分的修改或丢弃,都会使其偏离在某个epoch内的一致状态.

定理3和定理4保证了SSP和DPA审计交互过程中生成处于一致状态的审计历史,且该历史一旦生成就无法篡改.

综上,IDPA-MF-PDP的数据持有性审计是安全的.

5系统实现和实验评估5.

1系统实现我们在Linux平台上用C语言实现了IDPA-MF-PDP原型系统,同时实现了第4.

1节中提到的适用于文件组的DPDP方案以及基于单文件PDP方案[2]的原始MF_PDP方案作为对照,在后文中,分别用DPDP和PDP表示.

所有密码操作实现均来自于OpenSSL(版本号0.

9.

8o)[18].

我们采用两台配置相同的服务器来模拟云服务器和DPA:IntelXeon四核处理器,8G内存(主频2.

27GHz),10000r/m146GSAS硬盘.

由于可信硬件运算速度一般比云服务器慢,我们根据对测试平台测试获得的数据加入特定的减速因子,以模拟可信硬件的性能.

IBM4764每秒钟2410JournalofSoftware软件学报Vol.

27,No.

9,September2016能产生2.

16个长度为1024比特的RSA密钥对[17].

对比在测试平台获得的数据(14.

92个/s),我们设定可信硬件对大数运算的减速因子为6.

91.

测试文件大小在区间[0.

5GB,1GB]内均匀分布,分块大小为4KB.

为保证DPDP方案中文件组跳跃表层数最少以达到最高性能,我们将DPDP方案中各文件大小设为一致.

选择每次挑战块个数c=460,使得以99%的置信度检测1%的块损坏比例.

5.

2实验结果我们测试了IDPA-MF-PDP,DPDP和PDP方案的审计性能.

一次审计交互时间由4部分组成:云服务器读取挑战数据块的I/O时间、云服务器计算持有性证据的计算时间、DPA验证证据的时间和DPA与服务器的通信时间.

由于在我们的隐式第三方审计架构中DPA整合在云端,DPA和云服务器通信属于本地通信,且传输数据量为常数量级,其时间开销可忽略不计.

图8给出了IDPA-MF-PDP,DPDP和PDP的I/O时间开销.

由于IDPA-MF-PDP与DPDP的I/O内容几乎一致,且两个方案在挑战过程中选取的文件块数量均不随文件组大小变化,因此在图8中将两方案合并.

由图8可知:当文件组中的文件数目增加时,IDPA-MF-PDP/DPDP的I/O时间基本维持不变.

Fig.

8I/OoverheadofIDPA-MF-PDP/DPDPandPDP图8IDPA-MF-PDP和PDP的I/O开销图9(a)给出了IDPA-MF-PDP,DPDP和PDP方案在Prove阶段的计算时间.

IDPA-MF-PDP中,挑战块的数目不随文件组大小而更改,因此计算时间也不会增长;DPDP挑战块数目虽然恒定,但Prove阶段需根据跳跃表为每个挑战块计算验证路径,其耗时随文件块数目增长呈对数增长;而在PDP中,计算时间会随着挑战块数的线性增加而显著增长.

图9(b)给出了3个方案Verify过程的计算时间.

由于此过程由DPA验证,因此我们将所有数据乘以减速因子.

由图可知:即使Verify阶段整体上比Prove阶段耗时久,但是随着文件数目的增加,IDPA-MF-PDP的计算速度速度基本保持恒定,DPDP仍因维护跳跃表使耗时呈对数增加,PDP计算速度随文件数目增长最快(在Verify过程中,虽然DPA做了生成日志的工作,但测试结果表明,生成日志的时间基本恒定在3ms左右,对Verify时间影响甚微,因此忽略不计).

结合图8和图9可以看出,I/O开销占IDPA-MF-PDP审计开销的主要部分.

表2给出当文件组中文件数目为100时,IDPA-MF-PDP,DPDP和PDP总审计时间对比及其组成.

为了计算通信开销,我们将SSP与DPA之间的带宽设为100Mbps.

IDPA-MF-PDP的通信内容为一个文件块的聚合值及一个认证元的聚合值,易知,PDP的通信内容是其100倍.

根据文献[4],DPDP的Prove阶段,SSP返回给DPA的持有性证据包括c个文件块tag值、c个验证路径以及一个文件块聚合值,其中,每个验证路径包括logn+logTmax个哈希值.

除此之外,3个方案的通信内容均包含日志相关内容,其中,PDP日志开销为其余两个方案的100倍.

从表中可以看出:当文件数目增加时,IDPA-MF-PDP的审计时间和计算时间均保持在常量水平,而DPDP和PDP的审计时间和计算时间均有明显增加.

其中,DPDP传输验证路径哈希值的通信开销多至23.

4s,导致其总开销显著高于IDPA-MF-PDP.

20IDPA-MF-PDP/DPDPPDP50403020100Time(s)Numberoffiles101肖达等:面向真实云存储环境的数据持有性证明系统2411(a)IDPA-MF-PDP,DPDP和PDP在Prove阶段耗时比较(b)IDPA-MF-PDP,DPDP和PDP在Verify阶段耗时比较Fig.

9ComputationaloverheadinphaseProve,VerifyofIDPA-MF-PDP,DPDPandPDP图9IDPA-MF-PDP,DPDP和PDP在Prove和Verify阶段耗时比较Table2OverheadsofIDPA-MF-PDP,DPDPandPDP表2IDPA-MF-PDP,DPDP和PDP的时间开销时间开销IDPA-MF-PDP(s)DPDP(s)PDP(s)I/O4.

708(80.

15%)4.

6235.

5Prove0.

023(0.

39%)0.

3072.

3Verify1.

14(19.

41%)3.

356114.

015Communication0.

0003(0%)23.

3880.

032LogGeneration0.

003(0.

05%)0.

0030.

3Total5.

87431.

654352.

1476相关工作数据持有性和可取回性证明,近年来作为云存储安全中一个重要问题[19,20]已得到广泛关注.

Ateniese等人[2]和Juels,Kaliski[21]首先提出了数据持有性证明和可取回性证明的定义和方案.

Ateniese等人[2]定义了PDP模型,并且给出了更高效的实现方案——E-PDP.

在他们的方案中,通过随机抽样来减少检查的开销.

基于RSA的同态认证标签用来提供抽样块的集合值用于验证,因此,此方案支持公开验证.

同态认证元同样也是我们方案中的一个重要组成部分.

Ateniese等人的原始PDP方案只支持静态文件.

在他们的后续工作中,Ateniese等人提出了一个动态的PDP方案[3].

其基本思想是:在系统建立阶段,提出所有后续可能的挑战,并且把预计算的持有性证据当作元数据存储.

这样,验证端发起的挑战次数是限定的.

此外,每一次对于数据的更新都需要重新计算所有的挑战,这在大文件的存储中会出现问题.

Wang等人[5]研究了分布系统中的动态数据存储问题,他们的方案不仅可以判定数据的正确性,还可以定位数据出错的位置.

在他的另一个研究中[6],构造了一个整合了TTP公开审计和动态数据的方案.

全动态数据更新,特别是数据块的插入,通过用默克尔哈希树存储认证标签来实现.

Erway等人[4]对Ateniese提出的PDP模型[2]进行扩展,分别利用跳跃表(skiplist)和RSA树构建了基于秩次的认证字典,以此提出了支持全动态更新的PDP方案.

但是这个方案的更新操作的效率同样较低.

Li等人[7]提出了SN-BN表结构来支持数据块的插入操作,他们采用这个表将数据块的逻辑下标和实际位置对应起来.

在PDP过程中,通过序列号(SN)标识挑战的数据块,通过块号(BN)取得这些数据块.

当插入一个新数据块时,按照当前数据块的数目,顺序设定这个数据块的SN,以此来完成数据的更新.

以上支持动态数据的PDP方案[37]都针对一般的单文件更新,且方案复杂更新和检查开销较大,尤其是在简单扩展到处理多文件时(O(n)).

其中,只有文献[4]考虑了多文件检查问题,他们将多个可更新文件的组成和目录结构相同的树结构.

由于针对最一般的文件系统更新模式,使更新和检查复杂度为O(dlog2n),其中,d为树的深度,n为跳跃表中最大叶节点个数.

本文针对云存储中数据更新的特殊模式提出的MF-PDP方案,在保持方案200.

50.

40.

30.

20.

10.

0Time(s)Numberoffiles101IDPA-MF-PDPproveDPDPprovePDPprove202520151050Time(s)Numberoffiles101IDPA-MF-PDPverifyDPDPverifyPDPverify2412JournalofSoftware软件学报Vol.

27,No.

9,September2016简单性的同时,显著降低了多文件检查的开销(O(1)).

在Wang等人工作[6]的基础上,一些学者考虑了基于第三方审计的PDP方案的在实际云存储环境中部署所面临的问题和解决方案,主要集中在多SSP和可扩展性两个方面.

朱岩等人[8]考虑了多个SSP协同提供云存储服务的情形,基于多证明者零知识证明系统构造了协同PDP方案.

杨侃等人[9]在支持动态审计的同时,通过多用户和多SSP的批量审计进一步提高效率.

该思想和本文的MF-PDP类似,但他们并没有考虑多文件批量审计问题.

王化群等人[10]构造了多SSP环境下的基于身份的分布式PDP方案,提高系统的可扩展性.

这些方案都假设一个TTP的存在,而没有关注怎样以可操作的方式实现和部署TTP,也没有探讨在用户离线的情况下如何将TTP的审计结果返回给用户的问题.

与这些工作不同,本文并未给出某个具体基于第三方审计的PDP方案,而是提出一个一般的隐式TTP架构,用部署在云端的可信硬件实现隐式DPA,通过DPA和SSP的交互和显篡改审计日志支持用户离线审计.

需要指出:该架构具有和多种已有PDP方案集成的能力,本文的IDPA-MF-PDP即显示了该架构和一种特定的PDP方案——MF-PDP的集成.

7总结本文分析了现有PDP方案在真实云存储环境中应用存在的问题,并给出了一个解决方案:基于隐式第三方审计框架的多文件数据持有性证明系统IDPA-MF-PDP.

理论分析表明:IDPA-MF-PDP具有和单文件PDP方案等同的安全性,审计日志提供了可信的审计结果历史记录,IDPA-MF-PDP是安全的.

复杂度分析和实验结果表明:持有性审计的计算和通信开销由线性减少到接近常数水平,其性能主要受限于硬盘I/O能力,而非密码运算,IDPA-MF-PDP是高效的.

本文工作为最终实现可在真实云存储环境中部署的数据持有性证明提供了可能.

References:[1]FengDG,ZhangM,ZhangY,XuZ.

Studyoncloudcomputingsecurity.

RuanJianXueBao/JournalofSoftware,2011,22(1):7183(inChinesewithEnglishabstract).

http://www.

jos.

org.

cn/1000-9825/3958.

htm[doi:10.

3724/S.

P.

J.

1001.

2011.

03958][2]AtenieseG,BurnsR,CurtmolaR,HerringJ.

Provabledatapossessionatuntrustedstores.

In:NingP,DeCapitanidiVimercatiS,SyversonPF,eds.

Proc.

oftheACMConf.

onComputerandCommunicationsSecurity.

NewYork:ACMPress,2007.

598609.

[doi:10.

1145/1315245.

1315318][3]AtenieseG,PietroRD,ManciniLV,TsudikG.

Scalableandefficientprovabledatapossession.

In:Proc.

ofthe4thInt'lConf.

onSecurityandPrivacyinCommunicationNetworks.

NewYork:ACMPress,2008.

[doi:10.

1145/1460877.

1460889][4]ErwayC,KupcuA,PapamanthouC,TamassiaR.

Dynamicprovabledatapossession.

In:Al-ShaerE,JhaS,KeromytisAD,eds.

Proc.

oftheACMConf.

onComputerandCommunicationsSecurity.

NewYork:ACMPress,2009.

213222.

[doi:10.

1145/1653662.

1653688][5]WangC,WangQ,RenK,LouW.

Ensuringdatastoragesecurityincloudcomputing.

In:Proc.

ofthe2009IEEE17thInt'lWorkshoponQualityofService(IWQoS2009).

Piscataway:IEEE,2009.

19.

[doi:10.

1109/IWQoS.

2009.

5201385][6]WangQ,WangC,LiJ,RenK,LouW.

Enablingpublicverifiabilityanddatadynamicsforstoragesecurityincloudcomputing.

In:BackesM,NingP,eds.

Proc.

ofthe14thEuropeanSymp.

onResearchinComputerSecurity(ESORICS2009).

Saint-Malo,Berlin:Springer-Verlag.

2009.

355370.

[doi:10.

1007/978-3-642-04444-1_22][7]LiC,ChenY,TanP,YangG.

Anefficientprovabledatapossessionschemewithdatadynamics.

In:Proc.

ofthe2012Int'lConf.

onComputerScienceandServiceSystem.

Piscataway:IEEE,2012.

706710.

[doi:10.

1109/CSSS.

2012.

182][8]ZhuY,HuH,AhnH,YuM.

Cooperativeprovabledatapossessionforintegrityverificationinmulti-cloudstorage.

IEEETrans.

onParallelandDistributedSystems,2012,23(12):22312244.

[doi:10.

1109/TPDS.

2012.

66][9]YangK,JiaXH.

Anefficientandsecuredynamicauditingprotocolfordatastorageincloudcomputing.

IEEETrans.

onParallelandDistributedSystems,2013,24(9):17171726.

[doi:10.

1109/TPDS.

2012.

278][10]WangH.

Identity-Baseddistributedprovabledatapossessioninmulti-cloudstorage.

Trans.

onServicesComputing,2014,PP(99):1.

[doi:10.

1109/TSC.

2014.

1]肖达等:面向真实云存储环境的数据持有性证明系统2413[11]Internetandcloudservices—Statisticsontheusebyindividuals.

http://ec.

europa.

eu/eurostat/statistics-explained/index.

php/Internet_and_cloud_services_-_statistics_on_the_use_by_individuals[12]Librsync.

https://github.

com/dropbox/librsync[13]Tarsnap.

http://www.

tarsnap.

com/[14]VrableM,SavageS,VoelkerGM.

Cumulus:Filesystembackuptothecloud.

ACMTrans.

onStorage(TOS),2009,5(4):128.

[doi:10.

1145/1629080.

1629084][15]VrableM,SavageS,VoelkerGM.

BlueSky:Acloud-backedfilesystemfortheenterprise.

In:Proc.

ofthe10thUSENIXConf.

onFileandStorageTechnologies(FAST2012).

2012.

[16]XiaoD,YangY,YaoW,WuC,LiuJ,YangY.

Multiple-Fileremotedatacheckingforcloudstorage.

Computers&Security,2012,31(2):192205.

[doi:10.

1016/j.

cose.

2011.

12.

005][17]IBM4764PCI-Xcryptographiccoprocessor.

http://www-03.

ibm.

com/security/cryptocards/pcixcc/overperformance.

shtml[18]OpensslCryptoLibrary.

http://www.

openssl.

org/[19]ChenLX,XuL.

Researchonprovabledatapossessionandrecoverytechnologyincloudstorage.

JournalofComputerResearchandDevelopment,2012,49(Suppl.

):1925(inChinesewithEnglishabstract).

[20]FuYX,LuoSM,ShuJW.

Surveyofsecurecloudstoragesystemandkeytechnologies.

JournalofComputerResearchandDevelopment,2013,50(1):136145(inChinesewithEnglishabstract).

[21]JuelsA,KaliskiB.

PORs:Proofsofretrievabilityforlargefiles.

In:NingP,DeCapitanidiVimercatiS,SyversonPF,eds.

Proc.

oftheACMConf.

onComputerandCommunicationsSecurity.

NewYork:ACMPress,2007.

584597.

[doi:10.

1145/1315245.

1315317]附中文参考文献:[1]冯登国,张敏,张妍,徐震.

云计算安全研究.

软件学报,2011,22(1):7183.

http://www.

jos.

org.

cn/1000-9825/3958.

htm[doi:10.

3724/S.

P.

J.

1001.

2011.

03958][19]陈兰香,许力.

云存储服务中可证明数据持有及恢复技术研究.

计算机研究与发展,2012,49(Suppl.

):1925.

[20]傅颖勋,罗圣美,舒继武.

安全云存储系统与关键技术综述.

计算机研究与发展,2013,50(1):136145.

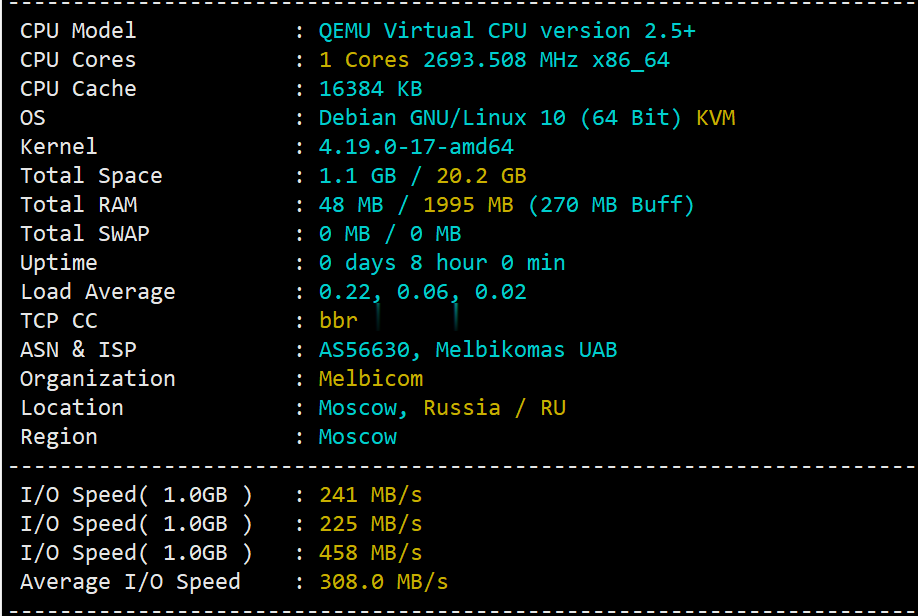

简单测评melbicom俄罗斯莫斯科数据中心的VPS,三网CN2回国,电信双程cn2

melbicom从2015年就开始运作了,在国内也是有一定的粉丝群,站长最早是从2017年开始介绍melbicom。上一次测评melbicom是在2018年,由于期间有不少人持续关注这个品牌,而且站长貌似也听说过路由什么的有变动的迹象。为此,今天重新对莫斯科数据中心的VPS进行一次简单测评,数据仅供参考。官方网站: https://melbicom.net比特币、信用卡、PayPal、支付宝、银联...

百星数据(60元/月,600元/年)日本/韩国/香港cn2 gia云服务器,2核2G/40G/5M带宽

百星数据(baixidc),2012年开始运作至今,主要提供境外自营云服务器和独立服务器出租业务,根据网络线路的不同划分为:美国cera 9929、美国cn2 gia、香港cn2 gia、韩国cn2 gia、日本cn2 gia等云服务器及物理服务器业务。目前,百星数据 推出的日本、韩国、香港cn2 gia云服务器,2核2G/40G/5M带宽低至60元/月,600元/年。百星数据优惠码:优惠码:30...

恒创新客(317元)香港云服务器 2M带宽 三网CN2线路直连

恒创科技也有暑期的活动,其中香港服务器也有一定折扣,当然是针对新用户的,如果我们还没有注册过或者可以有办法注册到新用户的,可以买他们家的香港服务器活动价格,2M带宽香港云服务器317元。对于一般用途还是够用的。 活动链接:恒创暑期活动爆款活动均是针对新用户的。1、云服务器仅限首次购买恒创科技产品的新用户。1 核 1G 实例规格,单个账户限购 1台;其他活动机型,单个账户限购 3 台(必须在一个订单...

-

ptrPTR是什么材料视频截图软件怎么在视频中剪切一张图片?用什么软件google竞价排名Google的竞价排名是怎么计费的主页改不了浏览器主页改不了 怎么办啊深圳公交车路线深圳公交车路线ps抠图技巧photoshop最基本的抠图方法和技巧!畅想中国畅想中国发展前景lockdowndios8.1能用gpp3to2吗?型号A1429ios系统ios是什么意思 ios系统是什么blogcn哪种博客更好...sina.baidu.blogcn还是.............?