大规模分布式存储系统hadoop开发和数据挖掘选哪个好

大规模分布式存储系统 时间:2021-05-28 阅读:()

哪本php书上有高并发,redis一类的

亲,php只是一门语言,高并发是适用于所有网站使用的,学习这门技术要具备以下知识: linux 服务器知识:推荐数据 鸟哥linux 网络工程 知识 硬件相关知识:了解即可网上搜搜 mysql数据库:mysql深入浅出,高性能mysql,把集群研究一下 Oracle(最好掌握,为了深入了解关系型数据库) 然后在 开始高并发之路 redis这属于nosql NoSQL精粹 Linux高性能服务器编程 Redis设计与实现 大规模分布式存储系统:原理解析与架构实战 大型网站技术架构 核心原理与案例分析 图灵程序设计丛书·实用负载均衡技术:网站性能优化攻略完美应对云环境及大数据 还有更深的外文书,有的是,那个不用看哪怕你在百度 都不用看,一般人做不到那个位置. 这个看完懂点儿 c语言 java能说会道 去个中小企业 当主管没什么问题 有些问题,这些书上也没有涉及,php 和java,网站如何实现对接,要去有点规模的公司实际工作中才能解除hadoop开发和数据挖掘选哪个好

1、SparkVSHadoop有哪些异同点?Hadoop:分布式批处理计算,强调批处理,常用于数据挖掘、分析Spark:是一个基于内存计算的开源的集群计算系统,目的是让数据分析更加快速,Spark是一种与Hadoop相似的开源集群计算环境,但是两者之间还存在一些不同之处,这些有用的不同之处使Spark在某些工作负载方面表现得更加优越,换句话说,Spark启用了内存分布数据集,除了能够提供交互式查询外,它还可以优化迭代工作负载。Spark是在Scala语言中实现的,它将Scala用作其应用程序框架。

与Hadoop不同,Spark和Scala能够紧密集成,其中的Scala可以像操作本地集合对象一样轻松地操作分布式数据集。

尽管创建Spark是为了支持分布式数据集上的迭代作业,但是实际上它是对Hadoop的补充,可以在Hadoop文件系统中并行运行。

通过名为Mesos的第三方集群框架可以支持此行为。

Spark由加州大学伯克利分校AMP实验室(Algorithms,Machines,andPeopleLab)开发,可用来构建大型的、低延迟的数据分析应用程序。

虽然Spark与Hadoop有相似之处,但它提供了具有有用差异的一个新的集群计算框架。

首先,Spark是为集群计算中的特定类型的工作负载而设计,即那些在并行操作之间重用工作数据集(比如机器学习算法)的工作负载。

为了优化这些类型的工作负载,Spark引进了内存集群计算的概念,可在内存集群计算中将数据集缓存在内存中,以缩短访问延迟.在大数据处理方面相信大家对hadoop已经耳熟能详,基于GoogleMap/Reduce来实现的Hadoop为开发者提供了map、reduce原语,使并行批处理程序变得非常地简单和优美。

Spark提供的数据集操作类型有很多种,不像Hadoop只提供了Map和Reduce两种操作。

比如map,filter,flatMap,sample,groupByKey,reduceByKey,union,join,cogroup,mapValues,sort,partionBy等多种操作类型,他们把这些操作称为Transformations。

同时还提供Count,collect,reduce,lookup,save等多种actions。

这些多种多样的数据集操作类型,给上层应用者提供了方便。

各个处理节点之间的通信模型不再像Hadoop那样就是唯一的DataShuffle一种模式。

用户可以命名,物化,控制中间结果的分区等。

可以说编程模型比Hadoop更灵活.2、Spark在容错性方面是否比其他工具更有优越性?从Spark的论文《ResilientDistributedDatasets:AFault-TolerantAbstractionforIn-MemoryClusterComputing》中没看出容错性做的有多好。

倒是提到了分布式数据集计算,做checkpoint的两种方式,一个是checkpointdata,一个是loggingtheupdates。

貌似Spark采用了后者。

但是文中后来又提到,虽然后者看似节省存储空间。

但是由于数据处理模型是类似DAG的操作过程,由于图中的某个节点出错,由于lineagechains的依赖复杂性,可能会引起全部计算节点的重新计算,这样成本也不低。

他们后来说,是存数据,还是存更新日志,做checkpoint还是由用户说了算吧。

相当于什么都没说,又把这个皮球踢给了用户。

所以我看就是由用户根据业务类型,衡量是存储数据IO和磁盘空间的代价和重新计算的代价,选择代价较小的一种策略。

取代给中间结果进行持久化或建立检查点,Spark会记住产生某些数据集的操作序列。

因此,当一个节点出现故障时,Spark会根据存储信息重新构造数据集。

他们认为这样也不错,因为其他节点将会帮助重建。

3、Spark对于数据处理能力和效率有哪些特色?Spark提供了高的性能和大数据处理能力,使得用户可以快速得到反馈体验更好。

另一类应用是做数据挖掘,因为Spark充分利用内存进行缓存,利用DAG消除不必要的步骤,所以比较合适做迭代式的运算。

而有相当一部分机器学习算法是通过多次迭代收敛的算法,所以适合用Spark来实现。

我们把一些常用的算法并行化用Spark实现,可以从R语言中方便地调用,降低了用户进行数据挖掘的学习成本。

Spark配有一个流数据处理模型,与Twitter的Storm框架相比,Spark采用了一种有趣而且独特的法。

Storm基本上是像是放入独立事务的管道,在其中事务会得到分布式的处理。

相反,Spark采用一个模型收集事务,然后在短时间内(我们假设是5秒)以批处理的方式处理事件。

所收集的数据成为他们自己的RDD,然后使用Spark应用程序中常用的一组进行处理。

作者声称这种模式是在缓慢节点和故障情况下会更加稳健,而且5秒的时间间隔通常对于大多数应用已经足够快了。

这种方法也很好地统一了流式处理与非流式处理部分。

总结这几天在看Hadoop权威指南、hbase权威指南、hive权威指南、大规模分布式存储系统、zoopkeeper、大数据互联网大规模数据挖掘与分布式处理等书同时补充,能静下心来好好的完整的看完一本书,是相当不错的。

- 大规模分布式存储系统hadoop开发和数据挖掘选哪个好相关文档

- 大规模分布式存储系统什么是分布式存储系统?

- 大规模分布式存储系统分布式文件系统的系统分类

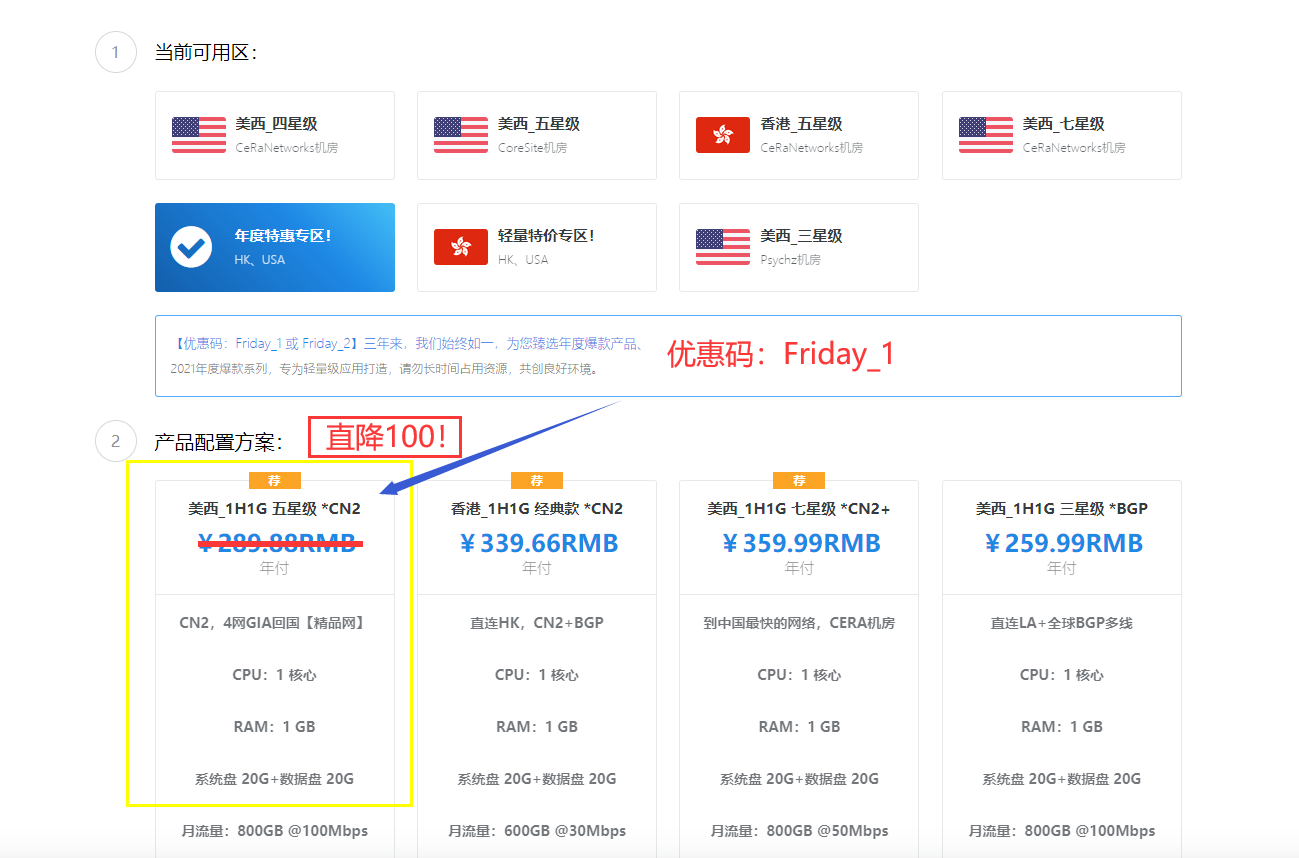

极光KVM(限时16元),洛杉矶三网CN2,cera机房,香港cn2

极光KVM创立于2018年,主要经营美国洛杉矶CN2机房、CeRaNetworks机房、中国香港CeraNetworks机房、香港CMI机房等产品。其中,洛杉矶提供CN2 GIA、CN2 GT以及常规BGP直连线路接入。从名字也可以看到,VPS产品全部是基于KVM架构的。极光KVM也有明确的更换IP政策,下单时选择“IP保险计划”多支付10块钱,可以在服务周期内免费更换一次IP,当然也可以不选择,...

Hosteons:新上1Gbps带宽KVM主机$21/年起,AMD Ryzen CPU+NVMe高性能主机$24/年起_韩国便宜服务器

我们在去年12月分享过Hosteons新上AMD Ryzen9 3900X CPU及DDR4内存、NVMe硬盘的高性能VPS产品的消息,目前商家再次发布了产品更新信息,暂停新开100M带宽KVM套餐,新订单转而升级为新的Budget KVM VPS(SSD)系列,带宽为1Gbps端口,且配置大幅升级,目前100M带宽仅保留OpenVZ架构产品可新订购,所有原有主机不变,用户一直续费一直可用。Bud...

bluehost32元/月,2核2G/20GB空间,独立ip,新一代VPS美国云主机!

bluehost怎么样?bluehost推出新一代VPS美国云主机!前几天,BlueHost也推出了对应的周年庆活动,全场海外虚拟主机月付2.95美元起,年付送免费的域名和SSL证书,通过活动进入BlueHost中文官网,购买虚拟主机、云虚拟主机和独立服务器参与限时促销。今天,云服务器网(yuntue.com)小编给大家介绍的是新一代VPS美国云主机,美国SSD云主机,2核2G/20GB空间,独立...

大规模分布式存储系统为你推荐

-

多ip云主机云主机怎么绑定多个域名魔兽世界配置要求玩魔兽世界电脑配置要求是怎样的?国外直播平台哪位大师知道国外的app直播软件?类似YY的。安装wget命令windows wget怎么安装linux路由跟踪LiNUX系统下,通过什么命令可以查看系统的路由表linux开放8080端口linux 如何将本地80端口的请求转发到8080端口,当前主机IP为192.168.2.1服务器日志分析软件有没有好点的IIS分析工具 求救!!!!!华为云服务登录电脑版华为账户必须要华为手机登入吗?云服务器可以干什么我们为什么选择云服务器?云服务器可以给我们带来什么实际的好处和价值?云主机能玩游戏吗买一个服务器可以用挂游戏吗?