文件系统南京虚拟主机

南京虚拟主机 时间:2021-01-27 阅读:()

收稿日期:20160622;修回日期:20160718基金项目:国家"863"计划重大资助项目(2013AA01A215);国家自然科学基金面上资助项目(61472323);西北工业大学基础研究基金资助项目(3102015JSJ0009);高效能服务器和存储技术国家重点实验室开放基金资助项目(2014HSSA11)作者简介:张伯阳(1990),男,硕士研究生,主要研究方向为云存储相关技术、本地文件系统(zhangboyang@mail.

nwpu.

edu.

cn);张晓(1978),男,副教授,硕导,主要研究方向为云计算、存储系统、分布式网络;李阿妮(1992),女,硕士研究生,主要研究方向云存储评测、本地文件系统;朱岩冰(1990),男,硕士研究生,主要研究方向为云存储评测、本地文件系统.

云存储系统可扩展性评测研究张伯阳1,张晓1,2,李阿妮1,朱岩冰1(1.

西北工业大学计算机学院,西安710129;2.

高效能服务器和存储技术国家重点实验室,济南250101)摘要:云存储系统中管理大规模数据的能力是云存储系统可拓展性的重要组成部分,而超大容量的测试需求是云存储系统可扩展性评测的难点.

针对此问题,分别在水平扩展和垂直扩展两个层面提出可扩展性评测方案,设计并实现了可扩展性评测工具———自动精简配置文件系统(thinprovisioningfilesystem,TPFS).

TPFS运行在云存储系统中的数据节点提供一定容量的实际存储空间和特定大小的元数据空间,并提供文件系统级别的自动精简配置,以此对云存储系统进行可扩展性评估.

实验结果表明,在实际空间仅为40GB的情况下,TPFS文件系统可以达到8TB规模的扩展性.

关键词:可扩展性;评测;自动精简配置;文件系统中图分类号:TP3027文献标志码:A文章编号:10013695(2017)07195705doi:10.

3969/j.

issn.

10013695.

2017.

07.

008ResearchonscalabilityevaluationincloudstoragesystemZhangBoyang1,ZhangXiao1,2,LiAni1,ZhuYanbing1(1.

SchoolofComputerScience,NorthwesternPolytechnicalUniversity,Xi'an710129,China;2.

StateKeyLaboratoryofHighendServer&StorageTechnology,Jinan250101,China)Abstract:Theabilityofmanaginglargescaledataincloudstoragesystemisanimportantpartofscalabilityofcloudstoragesystem.

However,intheevaluationofscalability,superlargecapacitytestenvironmentisthemostdifficultpart.

Tosolvethisproblem,thispaperproposedascalabilityevaluationplaninhorizontalexpansionandverticalexpansion,designedandimplementedanevaluationtool———TPFS.

TPFSwhichraninthedatanodesofcloudstoragesystemproviderealspacefordataandspecifiedspaceonlyformetadata,besidesitprovidedthinprovisioningintheleveloffilesystem,inordertoevaluatethescalabilityofcloudstoragesystem.

Theresultsshowthatwhentherealspaceisonly40GB,TPFSfilesystemcanreachthescalabilityof8TB.

Keywords:scalability;evaluation;thinprovisioning(TP);filesystem全球数据量的迅猛增长使得数据存储日益成为各企业关注的焦点,持续增长的数据存储压力带动了整个存储市场的快速发展,云计算和云存储迅速成为存储的热点[1].

随着数据量的日益增长,新设计的云存储系统容量也越来越大,现实应用中的Ceph[2,3]和HDFS[4]已经能够存储并管理PB级的数据.

在不久的未来,可扩展性达到EB级,甚至ZB级的云存储系统将问世,而如何对这些云存储系统的可扩展性进行评测是一个难点问题.

云存储环境下,若要达到EB级系统,至少需要105万块磁盘(2TB类型),其费用在10亿元人民币左右,故测试方无法实际搭建大规模的云存储系统.

针对这一问题,本文提出一种云存储系统可扩展性评测方案.

该方案使用自动精简[5]仿真的策略,对于云存储系统中的数据节点,在本地文件系统级别实现虚拟仿真.

自动精简配置(thinprovisioning,TP)是为了解决大多数企业存储设备空间利用率低下的问题而提出的存储理念,最初由DataCore公司在2002年提出并应用于存储产品[6].

该技术提供的是运行时空间,可以显著减少已分配但未使用的存储空间.

自动精简配置扩展了存储管理功能,可以用较小的物理容量为操作系统提供超大容量的虚拟存储空间[7].

本文提出的TPFS文件系统,在保证一定数据量真实存储的前提下,提供可变大小元数据存储,然后向上层操作系统汇报一个仿真后的文件系统容量,从而实现云存储系统总容量仿真.

此外,TPFS还支持自动精简配置,能够动态增加磁盘或云存储服务提供的块设备,这样可以提高设备的利用率;并且多块磁盘时,如果实现并行存储,那么文件系统数据吞吐率会得到提升.

1云存储系统可扩展性评测概述云存储系统由其内部网络中的大量服务器节点(管理节点、存储节点等)组成,而对于一个特定的云存储系统而言,其能够正常管理的最大节点数目,即云存储系统能够达到的最大规模是否存在限制,这在规模上决定了该系统的优劣,因此可扩展性是评价云存储系统的一个重要特性[8].

云存储系统可第34卷第7期2017年7月计算机应用研究ApplicationResearchofComputersVol34No7Jul.

2017扩展性至少包含两个维度上的可扩展性,即水平可扩展性和垂直可扩展性[9].

水平可扩展性是云存储系统内部能够管理多少个服务器节点,甚至是能否将其他多种云存储系统集成至自己内部的能力,即当云存储系统内部服务器节点数目增加时,云存储系统是否能够正常地(数据传输率、IOPS等性能平滑扩展)向用户提供与之相应的线性增长的存储空间.

垂直可扩展性是在云存储系统内部服务器节点数目不变的条件下,通过增大存储节点物理容量,云存储系统能够以相应比例扩容的能力.

这里,为了不影响云存储系统性能,在增大存储节点物理容量的同时,需要对存储节点CPU性能、内存大小等相关部件作相应提高,即存储节点其他部件应配合其物理容量提高作相应提升.

此外,云存储系统内部网络交换等部件也要作相应提升,以避免单纯提高云存储系统容量却造成云存储系统性能瓶颈的现象.

这里,为了满足日益增长的市场需求,一个存储节点应能够逐渐从一个单点存储服务器升级为一个存储服务器集群.

云存储系统中数据节点的扩展方式如图1所示.

图1云存储系统中数据节点的两种扩展方式云存储系统有别于传统的存储系统,其系统规模变化的频率远远高于传统存储系统,而这种变化不仅仅是正向变化,也存在负向变化,相应地需要考虑可扩展性的正向扩展和负向扩展.

因此,在评测中不仅需要分析正向扩展时系统再次恢复稳定的性能变化曲线,同时也要分析负向扩展的变化曲线,而且要将系统在扩展后重新恢复稳定的服务状态的时间作为重要的评价指标.

可扩展性评测整体目标如表1所示.

表1可扩展性评测目标一览表类型内容说明水平可扩展性外向扩展(scalingout)数据节点规模增大内向扩展(scalingin)数据节点规模减小垂直可扩展性向上扩展(scalingup)数据节点服务能力增强向下扩展(scalingdown)数据节点服务能力降低扩展代价时间代价扩展时所需的时间代价经济代价扩展时所需的经济代价在表1中,向上和向外扩展属于正向扩展,向下和向内扩展属于负向扩展.

在云存储系统中,数据节点是云存储文件系统的重要组成部分,不仅负责实际存储云存储文件系统的数据(元数据与实际数据),而且数据节点相互配合实现云存储层面的数据冗余备份.

数据节点通过与管理节点的通信,响应客户端对云存储文件系统的请求.

目前,大多数云存储系统在管理节点向客户端提供数据的读写位置后,客户端可以直接访问数据节点,这样提高了云存储系统的读写性能.

由于数据节点是云存储系统中存储部件的单位,所以本文对云存储系统可扩展性的研究均基于数据节点,分别从水平可扩展性和垂直可扩展性两方面对云存储系统进行虚拟仿真,从而完成对云存储系统可扩展性的研究.

水平扩展的实质是在磁盘容量恒定的情况下对磁盘数量的扩展.

依据扩展层面不同,对数据节点进行水平扩展有两种方法:一种是在数据节点层面增加数据节点数目,即数据节点扩展;另一种是在数据节点向云存储系统提供的本地文件系统层面,增加单个数据节点提供的文件系统数目,即数据节点上本地文件系统数量的扩展.

水平拓展可以通过虚拟机技术实现,利用如KVM、VMware、Xen等虚拟平台可在真实的物理节点上虚拟出多个节点,以便增加更多的磁盘数量,以此扩大数据节点的规模.

不同于水平扩展,垂直扩展的实质是在磁盘数量不变的情况下对磁盘容量的扩展.

传统存储节点中的硬盘已经达到较大容量,向上拓展空间小.

然而对于磁盘容量的仿真是一个难点.

又由于本地文件系统建立在磁盘之上,所以直接在本地文件系统层实现容量仿真.

由于文件数据分为元数据和实际数据两类,元数据记录数据的属性,一旦丢失或损毁将无法完成对实际数据的操作,所以在本地文件系统提供一定实际存储的基础上,可以开辟一块物理空间,只用来存储文件元数据,这样只需要元数据大小的空间就可以实现垂直方向上的扩展.

本文使用虚拟与仿真相结合的技术,将1个Rack的物理机,仿真出了410个RACK,并使存储系统达到EB级的环境,对存储系统进行了水平与垂直的双拓展.

2可扩展性评测工具设计与实现从垂直扩展方案的角度考虑,在本地文件系统层实现容量仿真.

在以往的技术当中[10,11],只是对磁盘进行自动精简,并没有对磁盘容量的大小进行仿真.

本工具基于Linux操作系统发行版默认的ext3文件系统(e2fsprogs1.

42.

12[12])设计并实现了TPFS,并对水平扩展所涉及的磁盘分区技术作了相关研究.

2.

1TPFS概述TPFS文件系统对数据节点容量进行仿真,属于垂直扩展,它位于云存储系统中的数据节点上,其直接管理下层磁盘或分区,向上层云存储文件系统提供接口,其在云存储系统中的位置如图2所示.

图2TPFS与云存储系统在云存储系统中,数据分为元数据和实际数据.

元数据记录实际数据的存放位置、修改时间、数据权限等信息,用来管理实际数据;实际数据是数据存储的实际载体.

显然,当元数据丢失后,云存储系统将无法对其所指向的实际数据进行读写操作,并且云存储系统管理主要涉及元数据,基于此,TPFS在虚·8591·计算机应用研究第34卷拟仿真部分仅仅对元数据进行存储,这样在保证云存储系统管理数据不丢失的情况下,实现了扩展性研究.

2.

2具体实现TPFS根据ext3文件系统修改而成,不仅包括格式化和内核部分,还包括一个显示程序,用于打印该文件系统实际存储空间与虚拟仿真空间.

如图3所示,整个TPFS文件系统由format、print和TPFS三部分组成,其中format和print运行在用户空间,通过调用操作系统提供的系统调用实现对磁盘或分区的操作;TPFS运行在内核空间,通过向上层VFS注册,实现对TPFS文件系统的读写操作.

图3TPFS文件系统组成Format对磁盘或分区进行初始化操作:获取总扇区数,对可用空间进行分组,清零inodebitmap和blockbitmap,将磁盘或分区的重要信息记录在superblock结构体中,并写在磁盘或分区上.

Format程序对磁盘或分区的格式化后,其物理布局如图4所示.

图4磁盘或分区布局图4中的MBS是masterbootsector,即主引导扇区,占用1KB空间;sb是superblock,即超级块,它记录了文件系统对磁盘或分区的所有信息,凭借sb中的信息,内核中的TPFS就能够实现对磁盘的精确读写;ext3格式部分使用ext3文件系统磁盘布局,提供一定真实数据的实际存储空间,此部分依照ext3分组并提供日志的模式存取数据;预留空间实现自动精简配置,当文件系统容量不足时可以动态添加设备对文件系统扩容.

本文提出了预留空间,其目的就是为了连接增加的一块新硬盘.

可以将预留空间作为存储连接拓展实际存储数据空间磁盘挂载目录和容量等基本信息的区域.

如图5所示,阈值点是TPFS文件系统中设定的逻辑块号,当阈值点前的空间被用尽时,其后的纯inode部分只存储元数据.

当存储数据超出阈值时,文件系统会提示用户增加硬盘以保证正常存储,否则只保存文件的元数据.

在增加硬盘后,系统会根据预留空间存储的连接信息,将原本因为超出阈值而只保存了此文件元数据的其余部分存入新增加的硬盘中,实现了动态拓展.

图5TPFS文件系统拓展根据云存储文件系统分块大小与inode大小的比例,以及欲仿真空间大小来设定此部分空间的大小,从而实现特定容量空间的仿真.

仿真容量计算公式如下:volsim=volinodesizeinode*sizefile(1)其中:volsim表示仿真容量;volinode表示纯inode部分容量;sizeinode表示TPFS文件系统中元数据结构体inode的大小,即128Byte;sizefile表示云存储系统分发至本地文件系统的文件平均大小.

显然,若需仿真大容量空间,需要利用sizefile来确定volinode,即纯inode部分的大小.

仿真比例计算公式如下:Rsim=volsimvolinode=sizefilesizeinode(2)其中:Rsim表示仿真比例,即仿真比例为实际文件平均大小与元数据inode大小之比.

TPFS文件系统仿真后容量计算公式如下:volFS=volD/P+volsim-volinode(3)其中:volFS表示仿真后文件系统总容量,volD/P表示磁盘或分区容量.

结合图4可知,TPFS用ext3格式部分为云存储系统提供实际的存储空间,用纯inode部分提供虚拟仿真的容量空间.

对于TPFS文件系统而言,一个文件的inode大小仅为128Byte,如果文件平均大小为10MB,纯inode空间为128MB,根据式(1)可知仿真容量为128MB/128Byte*10MB,即10TB;根据式(2)可知仿真比例为100GB/128MB=10MB/128Byte=81920.

目前市面上最大的企业级硬盘容量也不过8TB,在这样的仿真比例下,只需要很小的纯inode部分就可以仿真此大小,不过TPFS文件系统中ext3格式部分容量不应低于一个合理值,否则云存储系统将没有足够的实际空间存放其系统信息,这会造成云存储系统无法运作的后果.

2.

3文件操作流程由于本文提出的TPFS文件系统对磁盘或分区重新设计了数据分布方式,并且在实际写操作超出一定阈值时只存储元数据信息,即对文件的存储及管理方式在ext3文件系统的基础上作了改变.

如图6所示,对TPFS文件系统读写文件的流程进行描述.

图6TPFS文件系统写文件流程·9591·第7期张伯阳,等:云存储系统可扩展性评测研究2.

3.

1写文件流程当客户端向云存储系统monitor(即管理节点)请求创建并写文件时,调用云存储文件系统写文件API.

如果云存储文件系统使用了回写缓存机制,那么将立即对此API进行返回,然后再对本地文件系统进行实际操作;否则在此处阻塞调用,对本地文件系统进行写操作,然后再返回,最终由云存储文件系统向客户端返回写文件的结果.

对于本地文件系统TPFS层的写操作如图6所示,具体过程为:a)在收到写操作调用时,计算此次调用需要的逻辑块范围(逻辑块大小为4KB),判断写操作过程是否会越过阈值点.

b)如果写操作不会越过阈值点,那么在TPFS文件系统中的ext3格式部分使用ext3方式进行写操作.

在磁盘驱动完成实际写操作后,向云存储文件系统层返回API调用结果.

c)相反,如果写操作越过了阈值点,提示用户挂载新的磁盘;否则只保存元数据,在纯inode部分分别将inodebitmap对应的比特位置1,并将元数据信息写入其后的inodetable,然后依次返回API调用,最终完成写操作.

2.

3.

2读文件流程当客户端向云存储系统monitor(即管理节点)请求读文件时,调用云存储文件系统读文件API.

如果云存储文件系统使用了缓存机制,并且此次读文件缓存命中,那么将立即对此API进行返回,直接从云存储文件系统层返回,并将所读文件数据传给客户端;否则在此处阻塞,对本地文件系统进行读操作,然后再返回,最终由云存储文件系统向客户端返回所读取文件的数据(元数据与实际数据).

对于本地文件系统TPFS层的读操作如图7所示,具体过程为:a)在收到读操作调用时,根据TPFS文件系统上文件的inode号计算其所在逻辑块的块号,判断此块号是否越过阈值点.

b)如果没有越过阈值点,即该文件inode在ext3格式部分存储,亦即此文件对应的实际数据也在ext3格式部分实际存储,那么使用ext3方式进行读操作.

在磁盘驱动完成实际读操作后,向云存储文件系统层返回API调用,最终向客户端返回其所读取的文件.

c)如果inode所在逻辑块块号越过了阈值点,并且在预留的空间中没有找到新磁盘的信息,即该文件只有元数据被实际存储,那么只读取该文件的元数据,并用纯0填充元数据中显示的文件大小,然后依次返回API调用,最终由云存储系统将数据传给客户端.

图7TPFS文件系统读文件流程2.

4分区技术研究对于大规模云存储系统而言,磁盘数目有限,如果TPFS直接运行在磁盘之上,则提供给云存储系统使用的本地文件系统数目受限.

针对于此问题,本文对磁盘分区技术进行研究,将TPFS运行在磁盘分区之上,这样就解决了此问题.

目前有两种磁盘分区方式,一种是MBR(masterbootrecord,主引导记录)[13],另一种是GPT(globallyuniqueidentifierpartitiontable,GUID磁盘分区表,即全局唯一标志符磁盘分区表)[14].

自从1983年IBM公司发布DOS2.

0以来,MBR便是此操作系统的默认分区方式,由于其与BIOS的搭配,使其具有广泛的兼容性.

图8是MBR分区方式在磁盘上的典型布局.

图8MBR分区示意图由于MBR中分区表只有64Byte,而分区项占用16Byte,这样只能有四个分区;若分区数目多于四个,则必须借助扩展分区,在其上建立逻辑分区,且每个分区大小不能超过2TB.

由于操作系统及其配套分区工具fdisk的限制,其最大分区数为60,而且只有三个主分区,其余均为逻辑分区.

GPT分区方式由Intel公司开发,是新一代UEFI主板的重要组件,用于替代MBR.

图9是GPT分区方式在磁盘上的典型布局.

图9GPT分区方式示意图GPT分区方式第一个扇区是protectiveMBR(保护性MBR)与MBR一致,但其内的分区表一般不使用;其后的主GPTheader用于存储磁盘和分区属性信息;主GPT表用于存储分区项,其大小为16KB,远远大于MBR的64Byte,且单个分区项默认大小为128Byte,突破了MBR中分区大小不能超过2TB的限制,而且分区都是主分区.

其配套的gdisk、cgdisk和sgdisk分区工具甚至可以修改默认分区大小,从而使得最大分区数目达到182.

显然,GPT分区方式提供更多的分区数,且限制条件更少,这样借助TPFS就可以在仿真容量不变的情况下,将单个磁盘仿真为更大的容量空间.

3实验结果与分析3.

1正确性验证针对本文所述的可扩展性评测工具,本文在Ubuntu系统上对工具的正确性进行了验证.

首先使用format程序对需要模拟容量的磁盘进行格式化,然后指定内核中的TPFS类型进行挂载,最后查看到实际只有40GB的磁盘在TPFS文件系统层被仿真到了8TB,结果如图10所示.

3.

2EB级存储系统扩展性验证3.

2.

1搭建EB级环境在国家"863"重大项目"EB级云存储系统研制"中,要求验证国内某公司研制的存储系统能否拓展至EB级水平并进行测试.

根据此系统架构特点,结合实际物理资源,设计其EB·0691·计算机应用研究第34卷级测试网络拓扑,如图11所示.

图10TPFS文件系统仿真结果图11EB级存储系统拓扑图在图11中,由36个存储节点和2个Rack交换机组成EB级文件系统存储单元,其中存储节点提供物理存储空间,系统交换机将各个存储单元进行连接,访问入口为测试预留接口.

此结构在真实环境下搭建,按照每个存储硬盘6TB计算,大约需要18万块硬盘.

此公司单个Rack中有36个存储节点,每个存储节点72TB的存储容量,大约需要400个.

一个Rack的价格在200万人民币左右,那么构建一个真实的EB级系统存储需要8亿人民币.

但借助虚拟化工具KVM和可扩展性评测工具TPFS,采用物理+虚拟的方式,实现EB级存储系统.

使用虚拟化技术对系统进行水平拓展,增大节点的规模;借助可扩展性评测工具TPFS对每个存储节点再进行垂直拓展,增大每个节点的存储能力,就能够在保证测试环境下有效降低系统的物理规模.

在满足一个实际存储单元Rack的情况下,对存储单元Rack容量进行模拟.

如图12所示,使用一个存储单元Rack中的34台服务器作为虚拟机主机,每个服务器开启12个KVM虚拟机,每个虚拟机模拟2.

5PB存储空间.

完成了EB级环境的搭建,将测试的成本降至200万元.

这里对实际存储容量进行说明,TPFS为自动精简配置系统,当存储数据超出阈值时,文件系统会提示用户增加硬盘以保证正常存储,否则只保存文件的元数据.

文件系统底层默认文件大小为4MB,而TPFS保存的元数据大小为128Byte,所以其仿真比为4MB/128Byte=512KB.

实际存储容量为1.

5TB(实际给每个虚拟机分配的存储空间为2TB,此处除去操作系统和云存储服务的存储开销),则其可仿真的最大容量为15TB*512KB=768PB,所以其2.

5PB的仿真存储容量具有合理性.

3.

2.

2EB级仿真测试测试中主要对此文件系统的聚合带宽和元数据吞吐率进行了测试.

测试的结果表明,随着仿真规模的扩大,系统的性能不会因为仿真而衰减.

图12仿真拓展结构对EB级文件系统搭建过程中的各个阶段进行功能性读写测试,判断此文件系统读写是否正常.

测试过程中设定测试文件大小为4GB,客户端数目为1,测试进程数目为1,且测试读写请求块大小为1MB,测试结果如表2所示.

表2EB级存储系统各阶段读写测试虚拟仿真Rack数目141664256410写聚合带宽/MBps682728712690695640读聚合带宽/MBps30530828316990.

680对于元数据的测试,使用元数据吞吐量测评方法,分别对EB级存储系统搭建过程中各个阶段进行评测.

通过测试的数据也可以分析出,仿真出的EB级存储系统完全符合实际中的正常性能.

EB级存储系统各阶段元数据操作测试结果如表3所示.

表3EB级存储系统各阶段元数据操作测试结果虚拟机元数据操作/次/s11664256410create735712702700692remove9171034924912940chmod9861169115311251102stat26662667270126472557mkdir9341124110310731073read&seekdir3536363431opendir2164919939209692397218661rmdir885877110010751111表3中,随着虚拟仿真Rack数目的增加,各项元数据操作测试结果基本保持不变,是因为元数据服务器数量恒定,与理论相符.

至此,完成了对工具正确性、可用性的验证.

4结束语本文针对云存储系统可扩展性评测进行了水平扩展和垂直扩展两方面的分析,分别对这两个层面的可扩展性评测设计了评测方案,并且分别使用分区替代磁盘和TPFS文件系统层仿真的方法实现了评测方案,最后,对本文设计并实现的工具进行了验证.

TPFS不仅支持磁盘或分区,也支持iSCSI或云存储设备,且支持动态增删设备,与自动精简技术相结合,在本地文件系统层提供更多功能.

云存储系统往往需要对数据节点并发写,但是多个分区模拟磁盘时,会造成对同一磁盘的并发访问.

如何组合实际磁盘与仿真磁盘来规避这一问题,需要在未来进行更多的研究和实验.

此外,如何使仿真空间具有实际I/O表现,也是未来的研究方向.

(下转第1965页)·1691·第7期张伯阳,等:云存储系统可扩展性评测研究图2全路列车运行图京沪高铁停站方案图3优化的停站方案4.

3结果分析将原停站方案与优化的停站方案进行以下三方面的比较:a)均衡性对比.

对照原停站方案和优化的停站方案可以看出,原停站方案各列车的停站次数变化为[3,12];优化的停站方案列车停站次数相对均衡集中,变化为[6,11].

主要开行停9站列车和停10站列车,占开行列车总数的71.

8%.

b)可达性对比.

用Q(j)=∑39i=1(αjxij∑k≠jαkxik)来刻画车站Sj的可达性.

分别计算原停站方案和优化的停站方案中各车站Q(j)的值,通过分析得到:北京南、南京南、上海虹桥等必停站的可达性保持不变,泰安、滕州东、枣庄、镇江南、常州北、无锡东和苏州北等站的可达性均有一定改善,其他车站可达性下降,总体可达性略有提高.

c)综合对比.

根据式(1)(2)(6),由优化停站方案计算得到Z1=0.

39415,Z2=25026,Z3=Z1Z2=1.

57496*10-5;原停站方案计算得到Z′1=2.

65107,Z′2=24458,Z′3=Z′1/Z′2=108393*10-4.

通过对比可以看出,由遗传退火算法求解得到的优化停站方案的均衡性有显著提高,可达性指数提高约232%,总体效果良好.

5结束语为了制定合理的高速铁路列车停站方案,本文建立多目标非线性优化模型,并采用自适应的遗传退火算法进行求解,用京沪高速铁路进行验证,主要结论如下:a)自适应遗传算法控制全局的寻优方向,模拟退火的Metropolis邻域搜索策略提高算法的邻域搜索能力,两者结合能较快地获得全局较优解,计算结果合理,具有较好的优化质量.

b)优化的停站方案中各开行列车的停站次数相对均衡,保证了高速铁路的速度和技术优势.

c)优化的停站方案能更好地方便旅客的出行,对于吸引节点客流和提升铁路的竞争力能起到更好的效果.

由于实际的铁路条件更加复杂,研究存在许多不足之处,对于我国逐渐成型的高速铁路网,如何制定出优化的停站方案,是接下来需要深入研究的方向.

参考文献:[1]史峰,邓连波,黎新华.

客运专线相关旅客列车开行方案研究[J].

铁道学报,2004,26(2):1620.

[2]史峰,邓连波,霍亮.

旅客列车开行方案的双层规划模型和算法[J].

中国铁道科学,2007,28(3):110116.

[3]史峰,周文梁,陈彦.

基于弹性需求的旅客列车开行方案优化研究[J].

铁道学报,2008,30(3):16.

[4]徐瑞华,邹晓磊.

客运专线列车开行方案的优化方法研究[J].

同济大学学报:自然科学版,2005,33(12):16081612.

[5]张拥军,任民,杜文.

高速列车开行方案研究[J].

西南交通大学学报,1998,33(4):400404.

[6]兰淑梅.

京沪高速铁路客车开行方案有关问题的研究[J].

铁道运输与经济,2002,24(5):3235.

[7]何宇强,张好智,毛保华.

客运专线旅客列车开行方案的多目标双层规划模型[J].

铁道学报,2006,28(5):610.

[8]肖龙文,史峰.

铁路公交化旅客列车开行方案优化[J].

湖南大学学报,2009,38(1):8688.

[9]彭其渊.

客运专线运输组织[M].

北京:科学出版社,2007.

[10]郑锂,宋瑞,何世伟.

城市轨道交通跨站停车方案优化模型及算法[J].

铁道学报,2009,31(6):18.

[11]李得伟,韩宝明,李晓娟.

基于节点服务的高速铁路列车停站方案优化模型[J].

铁道学报,2013,35(6):15.

[12]赵鹏,杨浩.

京沪高速铁路列车开行模式的研究[J].

北京交通大学学报,2006,30(3):59.

[13]夏昭辉.

高速铁路旅客列车停站方案研究[D].

成都:西南交通大学,2015.

[14]吕红霞,涂玉渊,孙守平.

基于车站服务频率的高速列车停站设置研究[J].

铁道运输与经济,2014,36(8):3236.

[15]邓连波,史峰,周文梁.

旅客列车停站设置方案优化[J].

中国铁道科学,2009,30(4):102107.

[16]黄鉴,彭其渊.

高速列车停站优化问题的两阶段求解算法[J].

西南交通大学学报,2012,47(3):484489.

(上接第1961页)参考文献:[1]张龙立.

云存储技术探讨[J].

电信科学,2010(S1):7174.

[2]Ceph:thefutureofstorage[EB/OL].

(2015)[20150312].

http://ceph.

com/.

[3]GuduD,HardtM,StreitA.

EvaluatingtheperformanceandscalabilityoftheCephdistributedstoragesystem[C]//ProcofIEEEInternationalConferenceonBigData.

2014:177182.

[4]WhatisApacheHadoop[EB/OL].

(2014)[20150312].

http://hadoop.

apache.

org/.

[5]MaruthachalamD,MohantaT,SwainAR,etal.

Adistributedsystemdesignfornextgenerationstorageandremotereplication[C]//Procofthe5thInternationalConferenceonApplicationsofDigitalInformationandWebTechnologies.

2014:2227.

[6]张冬.

大话存储Ⅱ———存储系统架构与底层原理极限剖析[M].

北京:清华大学出版社,2011:603613.

[7]DeLucaA,BhideM.

Storagevirtualizationfordummies[M].

[S.

l.

]:WileyPublishingAustraliaPtyLtd,2009:5053.

[8]SuWenchi,ChangSE.

Integratedcloudstoragearchitectureforenhancingservicereliability,availabilityandscalability[C]//ProcofInternationalConferenceonInformationScience,ElectronicsandElectricalEngineering.

2014:764768.

[9]MeiLijun,ChanWK,TseTH.

Ataleofclouds:paradigmcomparisonsandsomethoughtsonresearchissues[C]//ProcofAsiaPacificServicesComputingConference.

2008:464469.

[10]ItzhackG,SondhiN.

Storagethinprovisioningandspacereclamation:U.

S.

PatentNo.

9,329,792[P].

20160503.

[11]Kawaguchi,Tomohiro.

Highavailabilityandlowcapacitythinprovisioning:U.

S.

PatentApplication12/053,514[P].

20080321.

[12]E2fsprogs:ext2/3/4filesystemutilities[EB/OL].

(20101022)[20150312].

http://e2fsprogs.

sourceforge.

net/.

[13]Masterbootrecord[EB/OL].

(2015)[20150510].

http://wiki.

archlinux.

org/index.

php/Master_Boot_Record.

[14]GUID_partition_table[EB/OL].

(2015)[20150510].

https://wiki.

archlinux.

org/index.

php/GUID_Partition_Table.

·5691·第7期张小炳,等:基于均衡性和可达性的高速铁路列车停站方案优化

nwpu.

edu.

cn);张晓(1978),男,副教授,硕导,主要研究方向为云计算、存储系统、分布式网络;李阿妮(1992),女,硕士研究生,主要研究方向云存储评测、本地文件系统;朱岩冰(1990),男,硕士研究生,主要研究方向为云存储评测、本地文件系统.

云存储系统可扩展性评测研究张伯阳1,张晓1,2,李阿妮1,朱岩冰1(1.

西北工业大学计算机学院,西安710129;2.

高效能服务器和存储技术国家重点实验室,济南250101)摘要:云存储系统中管理大规模数据的能力是云存储系统可拓展性的重要组成部分,而超大容量的测试需求是云存储系统可扩展性评测的难点.

针对此问题,分别在水平扩展和垂直扩展两个层面提出可扩展性评测方案,设计并实现了可扩展性评测工具———自动精简配置文件系统(thinprovisioningfilesystem,TPFS).

TPFS运行在云存储系统中的数据节点提供一定容量的实际存储空间和特定大小的元数据空间,并提供文件系统级别的自动精简配置,以此对云存储系统进行可扩展性评估.

实验结果表明,在实际空间仅为40GB的情况下,TPFS文件系统可以达到8TB规模的扩展性.

关键词:可扩展性;评测;自动精简配置;文件系统中图分类号:TP3027文献标志码:A文章编号:10013695(2017)07195705doi:10.

3969/j.

issn.

10013695.

2017.

07.

008ResearchonscalabilityevaluationincloudstoragesystemZhangBoyang1,ZhangXiao1,2,LiAni1,ZhuYanbing1(1.

SchoolofComputerScience,NorthwesternPolytechnicalUniversity,Xi'an710129,China;2.

StateKeyLaboratoryofHighendServer&StorageTechnology,Jinan250101,China)Abstract:Theabilityofmanaginglargescaledataincloudstoragesystemisanimportantpartofscalabilityofcloudstoragesystem.

However,intheevaluationofscalability,superlargecapacitytestenvironmentisthemostdifficultpart.

Tosolvethisproblem,thispaperproposedascalabilityevaluationplaninhorizontalexpansionandverticalexpansion,designedandimplementedanevaluationtool———TPFS.

TPFSwhichraninthedatanodesofcloudstoragesystemproviderealspacefordataandspecifiedspaceonlyformetadata,besidesitprovidedthinprovisioningintheleveloffilesystem,inordertoevaluatethescalabilityofcloudstoragesystem.

Theresultsshowthatwhentherealspaceisonly40GB,TPFSfilesystemcanreachthescalabilityof8TB.

Keywords:scalability;evaluation;thinprovisioning(TP);filesystem全球数据量的迅猛增长使得数据存储日益成为各企业关注的焦点,持续增长的数据存储压力带动了整个存储市场的快速发展,云计算和云存储迅速成为存储的热点[1].

随着数据量的日益增长,新设计的云存储系统容量也越来越大,现实应用中的Ceph[2,3]和HDFS[4]已经能够存储并管理PB级的数据.

在不久的未来,可扩展性达到EB级,甚至ZB级的云存储系统将问世,而如何对这些云存储系统的可扩展性进行评测是一个难点问题.

云存储环境下,若要达到EB级系统,至少需要105万块磁盘(2TB类型),其费用在10亿元人民币左右,故测试方无法实际搭建大规模的云存储系统.

针对这一问题,本文提出一种云存储系统可扩展性评测方案.

该方案使用自动精简[5]仿真的策略,对于云存储系统中的数据节点,在本地文件系统级别实现虚拟仿真.

自动精简配置(thinprovisioning,TP)是为了解决大多数企业存储设备空间利用率低下的问题而提出的存储理念,最初由DataCore公司在2002年提出并应用于存储产品[6].

该技术提供的是运行时空间,可以显著减少已分配但未使用的存储空间.

自动精简配置扩展了存储管理功能,可以用较小的物理容量为操作系统提供超大容量的虚拟存储空间[7].

本文提出的TPFS文件系统,在保证一定数据量真实存储的前提下,提供可变大小元数据存储,然后向上层操作系统汇报一个仿真后的文件系统容量,从而实现云存储系统总容量仿真.

此外,TPFS还支持自动精简配置,能够动态增加磁盘或云存储服务提供的块设备,这样可以提高设备的利用率;并且多块磁盘时,如果实现并行存储,那么文件系统数据吞吐率会得到提升.

1云存储系统可扩展性评测概述云存储系统由其内部网络中的大量服务器节点(管理节点、存储节点等)组成,而对于一个特定的云存储系统而言,其能够正常管理的最大节点数目,即云存储系统能够达到的最大规模是否存在限制,这在规模上决定了该系统的优劣,因此可扩展性是评价云存储系统的一个重要特性[8].

云存储系统可第34卷第7期2017年7月计算机应用研究ApplicationResearchofComputersVol34No7Jul.

2017扩展性至少包含两个维度上的可扩展性,即水平可扩展性和垂直可扩展性[9].

水平可扩展性是云存储系统内部能够管理多少个服务器节点,甚至是能否将其他多种云存储系统集成至自己内部的能力,即当云存储系统内部服务器节点数目增加时,云存储系统是否能够正常地(数据传输率、IOPS等性能平滑扩展)向用户提供与之相应的线性增长的存储空间.

垂直可扩展性是在云存储系统内部服务器节点数目不变的条件下,通过增大存储节点物理容量,云存储系统能够以相应比例扩容的能力.

这里,为了不影响云存储系统性能,在增大存储节点物理容量的同时,需要对存储节点CPU性能、内存大小等相关部件作相应提高,即存储节点其他部件应配合其物理容量提高作相应提升.

此外,云存储系统内部网络交换等部件也要作相应提升,以避免单纯提高云存储系统容量却造成云存储系统性能瓶颈的现象.

这里,为了满足日益增长的市场需求,一个存储节点应能够逐渐从一个单点存储服务器升级为一个存储服务器集群.

云存储系统中数据节点的扩展方式如图1所示.

图1云存储系统中数据节点的两种扩展方式云存储系统有别于传统的存储系统,其系统规模变化的频率远远高于传统存储系统,而这种变化不仅仅是正向变化,也存在负向变化,相应地需要考虑可扩展性的正向扩展和负向扩展.

因此,在评测中不仅需要分析正向扩展时系统再次恢复稳定的性能变化曲线,同时也要分析负向扩展的变化曲线,而且要将系统在扩展后重新恢复稳定的服务状态的时间作为重要的评价指标.

可扩展性评测整体目标如表1所示.

表1可扩展性评测目标一览表类型内容说明水平可扩展性外向扩展(scalingout)数据节点规模增大内向扩展(scalingin)数据节点规模减小垂直可扩展性向上扩展(scalingup)数据节点服务能力增强向下扩展(scalingdown)数据节点服务能力降低扩展代价时间代价扩展时所需的时间代价经济代价扩展时所需的经济代价在表1中,向上和向外扩展属于正向扩展,向下和向内扩展属于负向扩展.

在云存储系统中,数据节点是云存储文件系统的重要组成部分,不仅负责实际存储云存储文件系统的数据(元数据与实际数据),而且数据节点相互配合实现云存储层面的数据冗余备份.

数据节点通过与管理节点的通信,响应客户端对云存储文件系统的请求.

目前,大多数云存储系统在管理节点向客户端提供数据的读写位置后,客户端可以直接访问数据节点,这样提高了云存储系统的读写性能.

由于数据节点是云存储系统中存储部件的单位,所以本文对云存储系统可扩展性的研究均基于数据节点,分别从水平可扩展性和垂直可扩展性两方面对云存储系统进行虚拟仿真,从而完成对云存储系统可扩展性的研究.

水平扩展的实质是在磁盘容量恒定的情况下对磁盘数量的扩展.

依据扩展层面不同,对数据节点进行水平扩展有两种方法:一种是在数据节点层面增加数据节点数目,即数据节点扩展;另一种是在数据节点向云存储系统提供的本地文件系统层面,增加单个数据节点提供的文件系统数目,即数据节点上本地文件系统数量的扩展.

水平拓展可以通过虚拟机技术实现,利用如KVM、VMware、Xen等虚拟平台可在真实的物理节点上虚拟出多个节点,以便增加更多的磁盘数量,以此扩大数据节点的规模.

不同于水平扩展,垂直扩展的实质是在磁盘数量不变的情况下对磁盘容量的扩展.

传统存储节点中的硬盘已经达到较大容量,向上拓展空间小.

然而对于磁盘容量的仿真是一个难点.

又由于本地文件系统建立在磁盘之上,所以直接在本地文件系统层实现容量仿真.

由于文件数据分为元数据和实际数据两类,元数据记录数据的属性,一旦丢失或损毁将无法完成对实际数据的操作,所以在本地文件系统提供一定实际存储的基础上,可以开辟一块物理空间,只用来存储文件元数据,这样只需要元数据大小的空间就可以实现垂直方向上的扩展.

本文使用虚拟与仿真相结合的技术,将1个Rack的物理机,仿真出了410个RACK,并使存储系统达到EB级的环境,对存储系统进行了水平与垂直的双拓展.

2可扩展性评测工具设计与实现从垂直扩展方案的角度考虑,在本地文件系统层实现容量仿真.

在以往的技术当中[10,11],只是对磁盘进行自动精简,并没有对磁盘容量的大小进行仿真.

本工具基于Linux操作系统发行版默认的ext3文件系统(e2fsprogs1.

42.

12[12])设计并实现了TPFS,并对水平扩展所涉及的磁盘分区技术作了相关研究.

2.

1TPFS概述TPFS文件系统对数据节点容量进行仿真,属于垂直扩展,它位于云存储系统中的数据节点上,其直接管理下层磁盘或分区,向上层云存储文件系统提供接口,其在云存储系统中的位置如图2所示.

图2TPFS与云存储系统在云存储系统中,数据分为元数据和实际数据.

元数据记录实际数据的存放位置、修改时间、数据权限等信息,用来管理实际数据;实际数据是数据存储的实际载体.

显然,当元数据丢失后,云存储系统将无法对其所指向的实际数据进行读写操作,并且云存储系统管理主要涉及元数据,基于此,TPFS在虚·8591·计算机应用研究第34卷拟仿真部分仅仅对元数据进行存储,这样在保证云存储系统管理数据不丢失的情况下,实现了扩展性研究.

2.

2具体实现TPFS根据ext3文件系统修改而成,不仅包括格式化和内核部分,还包括一个显示程序,用于打印该文件系统实际存储空间与虚拟仿真空间.

如图3所示,整个TPFS文件系统由format、print和TPFS三部分组成,其中format和print运行在用户空间,通过调用操作系统提供的系统调用实现对磁盘或分区的操作;TPFS运行在内核空间,通过向上层VFS注册,实现对TPFS文件系统的读写操作.

图3TPFS文件系统组成Format对磁盘或分区进行初始化操作:获取总扇区数,对可用空间进行分组,清零inodebitmap和blockbitmap,将磁盘或分区的重要信息记录在superblock结构体中,并写在磁盘或分区上.

Format程序对磁盘或分区的格式化后,其物理布局如图4所示.

图4磁盘或分区布局图4中的MBS是masterbootsector,即主引导扇区,占用1KB空间;sb是superblock,即超级块,它记录了文件系统对磁盘或分区的所有信息,凭借sb中的信息,内核中的TPFS就能够实现对磁盘的精确读写;ext3格式部分使用ext3文件系统磁盘布局,提供一定真实数据的实际存储空间,此部分依照ext3分组并提供日志的模式存取数据;预留空间实现自动精简配置,当文件系统容量不足时可以动态添加设备对文件系统扩容.

本文提出了预留空间,其目的就是为了连接增加的一块新硬盘.

可以将预留空间作为存储连接拓展实际存储数据空间磁盘挂载目录和容量等基本信息的区域.

如图5所示,阈值点是TPFS文件系统中设定的逻辑块号,当阈值点前的空间被用尽时,其后的纯inode部分只存储元数据.

当存储数据超出阈值时,文件系统会提示用户增加硬盘以保证正常存储,否则只保存文件的元数据.

在增加硬盘后,系统会根据预留空间存储的连接信息,将原本因为超出阈值而只保存了此文件元数据的其余部分存入新增加的硬盘中,实现了动态拓展.

图5TPFS文件系统拓展根据云存储文件系统分块大小与inode大小的比例,以及欲仿真空间大小来设定此部分空间的大小,从而实现特定容量空间的仿真.

仿真容量计算公式如下:volsim=volinodesizeinode*sizefile(1)其中:volsim表示仿真容量;volinode表示纯inode部分容量;sizeinode表示TPFS文件系统中元数据结构体inode的大小,即128Byte;sizefile表示云存储系统分发至本地文件系统的文件平均大小.

显然,若需仿真大容量空间,需要利用sizefile来确定volinode,即纯inode部分的大小.

仿真比例计算公式如下:Rsim=volsimvolinode=sizefilesizeinode(2)其中:Rsim表示仿真比例,即仿真比例为实际文件平均大小与元数据inode大小之比.

TPFS文件系统仿真后容量计算公式如下:volFS=volD/P+volsim-volinode(3)其中:volFS表示仿真后文件系统总容量,volD/P表示磁盘或分区容量.

结合图4可知,TPFS用ext3格式部分为云存储系统提供实际的存储空间,用纯inode部分提供虚拟仿真的容量空间.

对于TPFS文件系统而言,一个文件的inode大小仅为128Byte,如果文件平均大小为10MB,纯inode空间为128MB,根据式(1)可知仿真容量为128MB/128Byte*10MB,即10TB;根据式(2)可知仿真比例为100GB/128MB=10MB/128Byte=81920.

目前市面上最大的企业级硬盘容量也不过8TB,在这样的仿真比例下,只需要很小的纯inode部分就可以仿真此大小,不过TPFS文件系统中ext3格式部分容量不应低于一个合理值,否则云存储系统将没有足够的实际空间存放其系统信息,这会造成云存储系统无法运作的后果.

2.

3文件操作流程由于本文提出的TPFS文件系统对磁盘或分区重新设计了数据分布方式,并且在实际写操作超出一定阈值时只存储元数据信息,即对文件的存储及管理方式在ext3文件系统的基础上作了改变.

如图6所示,对TPFS文件系统读写文件的流程进行描述.

图6TPFS文件系统写文件流程·9591·第7期张伯阳,等:云存储系统可扩展性评测研究2.

3.

1写文件流程当客户端向云存储系统monitor(即管理节点)请求创建并写文件时,调用云存储文件系统写文件API.

如果云存储文件系统使用了回写缓存机制,那么将立即对此API进行返回,然后再对本地文件系统进行实际操作;否则在此处阻塞调用,对本地文件系统进行写操作,然后再返回,最终由云存储文件系统向客户端返回写文件的结果.

对于本地文件系统TPFS层的写操作如图6所示,具体过程为:a)在收到写操作调用时,计算此次调用需要的逻辑块范围(逻辑块大小为4KB),判断写操作过程是否会越过阈值点.

b)如果写操作不会越过阈值点,那么在TPFS文件系统中的ext3格式部分使用ext3方式进行写操作.

在磁盘驱动完成实际写操作后,向云存储文件系统层返回API调用结果.

c)相反,如果写操作越过了阈值点,提示用户挂载新的磁盘;否则只保存元数据,在纯inode部分分别将inodebitmap对应的比特位置1,并将元数据信息写入其后的inodetable,然后依次返回API调用,最终完成写操作.

2.

3.

2读文件流程当客户端向云存储系统monitor(即管理节点)请求读文件时,调用云存储文件系统读文件API.

如果云存储文件系统使用了缓存机制,并且此次读文件缓存命中,那么将立即对此API进行返回,直接从云存储文件系统层返回,并将所读文件数据传给客户端;否则在此处阻塞,对本地文件系统进行读操作,然后再返回,最终由云存储文件系统向客户端返回所读取文件的数据(元数据与实际数据).

对于本地文件系统TPFS层的读操作如图7所示,具体过程为:a)在收到读操作调用时,根据TPFS文件系统上文件的inode号计算其所在逻辑块的块号,判断此块号是否越过阈值点.

b)如果没有越过阈值点,即该文件inode在ext3格式部分存储,亦即此文件对应的实际数据也在ext3格式部分实际存储,那么使用ext3方式进行读操作.

在磁盘驱动完成实际读操作后,向云存储文件系统层返回API调用,最终向客户端返回其所读取的文件.

c)如果inode所在逻辑块块号越过了阈值点,并且在预留的空间中没有找到新磁盘的信息,即该文件只有元数据被实际存储,那么只读取该文件的元数据,并用纯0填充元数据中显示的文件大小,然后依次返回API调用,最终由云存储系统将数据传给客户端.

图7TPFS文件系统读文件流程2.

4分区技术研究对于大规模云存储系统而言,磁盘数目有限,如果TPFS直接运行在磁盘之上,则提供给云存储系统使用的本地文件系统数目受限.

针对于此问题,本文对磁盘分区技术进行研究,将TPFS运行在磁盘分区之上,这样就解决了此问题.

目前有两种磁盘分区方式,一种是MBR(masterbootrecord,主引导记录)[13],另一种是GPT(globallyuniqueidentifierpartitiontable,GUID磁盘分区表,即全局唯一标志符磁盘分区表)[14].

自从1983年IBM公司发布DOS2.

0以来,MBR便是此操作系统的默认分区方式,由于其与BIOS的搭配,使其具有广泛的兼容性.

图8是MBR分区方式在磁盘上的典型布局.

图8MBR分区示意图由于MBR中分区表只有64Byte,而分区项占用16Byte,这样只能有四个分区;若分区数目多于四个,则必须借助扩展分区,在其上建立逻辑分区,且每个分区大小不能超过2TB.

由于操作系统及其配套分区工具fdisk的限制,其最大分区数为60,而且只有三个主分区,其余均为逻辑分区.

GPT分区方式由Intel公司开发,是新一代UEFI主板的重要组件,用于替代MBR.

图9是GPT分区方式在磁盘上的典型布局.

图9GPT分区方式示意图GPT分区方式第一个扇区是protectiveMBR(保护性MBR)与MBR一致,但其内的分区表一般不使用;其后的主GPTheader用于存储磁盘和分区属性信息;主GPT表用于存储分区项,其大小为16KB,远远大于MBR的64Byte,且单个分区项默认大小为128Byte,突破了MBR中分区大小不能超过2TB的限制,而且分区都是主分区.

其配套的gdisk、cgdisk和sgdisk分区工具甚至可以修改默认分区大小,从而使得最大分区数目达到182.

显然,GPT分区方式提供更多的分区数,且限制条件更少,这样借助TPFS就可以在仿真容量不变的情况下,将单个磁盘仿真为更大的容量空间.

3实验结果与分析3.

1正确性验证针对本文所述的可扩展性评测工具,本文在Ubuntu系统上对工具的正确性进行了验证.

首先使用format程序对需要模拟容量的磁盘进行格式化,然后指定内核中的TPFS类型进行挂载,最后查看到实际只有40GB的磁盘在TPFS文件系统层被仿真到了8TB,结果如图10所示.

3.

2EB级存储系统扩展性验证3.

2.

1搭建EB级环境在国家"863"重大项目"EB级云存储系统研制"中,要求验证国内某公司研制的存储系统能否拓展至EB级水平并进行测试.

根据此系统架构特点,结合实际物理资源,设计其EB·0691·计算机应用研究第34卷级测试网络拓扑,如图11所示.

图10TPFS文件系统仿真结果图11EB级存储系统拓扑图在图11中,由36个存储节点和2个Rack交换机组成EB级文件系统存储单元,其中存储节点提供物理存储空间,系统交换机将各个存储单元进行连接,访问入口为测试预留接口.

此结构在真实环境下搭建,按照每个存储硬盘6TB计算,大约需要18万块硬盘.

此公司单个Rack中有36个存储节点,每个存储节点72TB的存储容量,大约需要400个.

一个Rack的价格在200万人民币左右,那么构建一个真实的EB级系统存储需要8亿人民币.

但借助虚拟化工具KVM和可扩展性评测工具TPFS,采用物理+虚拟的方式,实现EB级存储系统.

使用虚拟化技术对系统进行水平拓展,增大节点的规模;借助可扩展性评测工具TPFS对每个存储节点再进行垂直拓展,增大每个节点的存储能力,就能够在保证测试环境下有效降低系统的物理规模.

在满足一个实际存储单元Rack的情况下,对存储单元Rack容量进行模拟.

如图12所示,使用一个存储单元Rack中的34台服务器作为虚拟机主机,每个服务器开启12个KVM虚拟机,每个虚拟机模拟2.

5PB存储空间.

完成了EB级环境的搭建,将测试的成本降至200万元.

这里对实际存储容量进行说明,TPFS为自动精简配置系统,当存储数据超出阈值时,文件系统会提示用户增加硬盘以保证正常存储,否则只保存文件的元数据.

文件系统底层默认文件大小为4MB,而TPFS保存的元数据大小为128Byte,所以其仿真比为4MB/128Byte=512KB.

实际存储容量为1.

5TB(实际给每个虚拟机分配的存储空间为2TB,此处除去操作系统和云存储服务的存储开销),则其可仿真的最大容量为15TB*512KB=768PB,所以其2.

5PB的仿真存储容量具有合理性.

3.

2.

2EB级仿真测试测试中主要对此文件系统的聚合带宽和元数据吞吐率进行了测试.

测试的结果表明,随着仿真规模的扩大,系统的性能不会因为仿真而衰减.

图12仿真拓展结构对EB级文件系统搭建过程中的各个阶段进行功能性读写测试,判断此文件系统读写是否正常.

测试过程中设定测试文件大小为4GB,客户端数目为1,测试进程数目为1,且测试读写请求块大小为1MB,测试结果如表2所示.

表2EB级存储系统各阶段读写测试虚拟仿真Rack数目141664256410写聚合带宽/MBps682728712690695640读聚合带宽/MBps30530828316990.

680对于元数据的测试,使用元数据吞吐量测评方法,分别对EB级存储系统搭建过程中各个阶段进行评测.

通过测试的数据也可以分析出,仿真出的EB级存储系统完全符合实际中的正常性能.

EB级存储系统各阶段元数据操作测试结果如表3所示.

表3EB级存储系统各阶段元数据操作测试结果虚拟机元数据操作/次/s11664256410create735712702700692remove9171034924912940chmod9861169115311251102stat26662667270126472557mkdir9341124110310731073read&seekdir3536363431opendir2164919939209692397218661rmdir885877110010751111表3中,随着虚拟仿真Rack数目的增加,各项元数据操作测试结果基本保持不变,是因为元数据服务器数量恒定,与理论相符.

至此,完成了对工具正确性、可用性的验证.

4结束语本文针对云存储系统可扩展性评测进行了水平扩展和垂直扩展两方面的分析,分别对这两个层面的可扩展性评测设计了评测方案,并且分别使用分区替代磁盘和TPFS文件系统层仿真的方法实现了评测方案,最后,对本文设计并实现的工具进行了验证.

TPFS不仅支持磁盘或分区,也支持iSCSI或云存储设备,且支持动态增删设备,与自动精简技术相结合,在本地文件系统层提供更多功能.

云存储系统往往需要对数据节点并发写,但是多个分区模拟磁盘时,会造成对同一磁盘的并发访问.

如何组合实际磁盘与仿真磁盘来规避这一问题,需要在未来进行更多的研究和实验.

此外,如何使仿真空间具有实际I/O表现,也是未来的研究方向.

(下转第1965页)·1691·第7期张伯阳,等:云存储系统可扩展性评测研究图2全路列车运行图京沪高铁停站方案图3优化的停站方案4.

3结果分析将原停站方案与优化的停站方案进行以下三方面的比较:a)均衡性对比.

对照原停站方案和优化的停站方案可以看出,原停站方案各列车的停站次数变化为[3,12];优化的停站方案列车停站次数相对均衡集中,变化为[6,11].

主要开行停9站列车和停10站列车,占开行列车总数的71.

8%.

b)可达性对比.

用Q(j)=∑39i=1(αjxij∑k≠jαkxik)来刻画车站Sj的可达性.

分别计算原停站方案和优化的停站方案中各车站Q(j)的值,通过分析得到:北京南、南京南、上海虹桥等必停站的可达性保持不变,泰安、滕州东、枣庄、镇江南、常州北、无锡东和苏州北等站的可达性均有一定改善,其他车站可达性下降,总体可达性略有提高.

c)综合对比.

根据式(1)(2)(6),由优化停站方案计算得到Z1=0.

39415,Z2=25026,Z3=Z1Z2=1.

57496*10-5;原停站方案计算得到Z′1=2.

65107,Z′2=24458,Z′3=Z′1/Z′2=108393*10-4.

通过对比可以看出,由遗传退火算法求解得到的优化停站方案的均衡性有显著提高,可达性指数提高约232%,总体效果良好.

5结束语为了制定合理的高速铁路列车停站方案,本文建立多目标非线性优化模型,并采用自适应的遗传退火算法进行求解,用京沪高速铁路进行验证,主要结论如下:a)自适应遗传算法控制全局的寻优方向,模拟退火的Metropolis邻域搜索策略提高算法的邻域搜索能力,两者结合能较快地获得全局较优解,计算结果合理,具有较好的优化质量.

b)优化的停站方案中各开行列车的停站次数相对均衡,保证了高速铁路的速度和技术优势.

c)优化的停站方案能更好地方便旅客的出行,对于吸引节点客流和提升铁路的竞争力能起到更好的效果.

由于实际的铁路条件更加复杂,研究存在许多不足之处,对于我国逐渐成型的高速铁路网,如何制定出优化的停站方案,是接下来需要深入研究的方向.

参考文献:[1]史峰,邓连波,黎新华.

客运专线相关旅客列车开行方案研究[J].

铁道学报,2004,26(2):1620.

[2]史峰,邓连波,霍亮.

旅客列车开行方案的双层规划模型和算法[J].

中国铁道科学,2007,28(3):110116.

[3]史峰,周文梁,陈彦.

基于弹性需求的旅客列车开行方案优化研究[J].

铁道学报,2008,30(3):16.

[4]徐瑞华,邹晓磊.

客运专线列车开行方案的优化方法研究[J].

同济大学学报:自然科学版,2005,33(12):16081612.

[5]张拥军,任民,杜文.

高速列车开行方案研究[J].

西南交通大学学报,1998,33(4):400404.

[6]兰淑梅.

京沪高速铁路客车开行方案有关问题的研究[J].

铁道运输与经济,2002,24(5):3235.

[7]何宇强,张好智,毛保华.

客运专线旅客列车开行方案的多目标双层规划模型[J].

铁道学报,2006,28(5):610.

[8]肖龙文,史峰.

铁路公交化旅客列车开行方案优化[J].

湖南大学学报,2009,38(1):8688.

[9]彭其渊.

客运专线运输组织[M].

北京:科学出版社,2007.

[10]郑锂,宋瑞,何世伟.

城市轨道交通跨站停车方案优化模型及算法[J].

铁道学报,2009,31(6):18.

[11]李得伟,韩宝明,李晓娟.

基于节点服务的高速铁路列车停站方案优化模型[J].

铁道学报,2013,35(6):15.

[12]赵鹏,杨浩.

京沪高速铁路列车开行模式的研究[J].

北京交通大学学报,2006,30(3):59.

[13]夏昭辉.

高速铁路旅客列车停站方案研究[D].

成都:西南交通大学,2015.

[14]吕红霞,涂玉渊,孙守平.

基于车站服务频率的高速列车停站设置研究[J].

铁道运输与经济,2014,36(8):3236.

[15]邓连波,史峰,周文梁.

旅客列车停站设置方案优化[J].

中国铁道科学,2009,30(4):102107.

[16]黄鉴,彭其渊.

高速列车停站优化问题的两阶段求解算法[J].

西南交通大学学报,2012,47(3):484489.

(上接第1961页)参考文献:[1]张龙立.

云存储技术探讨[J].

电信科学,2010(S1):7174.

[2]Ceph:thefutureofstorage[EB/OL].

(2015)[20150312].

http://ceph.

com/.

[3]GuduD,HardtM,StreitA.

EvaluatingtheperformanceandscalabilityoftheCephdistributedstoragesystem[C]//ProcofIEEEInternationalConferenceonBigData.

2014:177182.

[4]WhatisApacheHadoop[EB/OL].

(2014)[20150312].

http://hadoop.

apache.

org/.

[5]MaruthachalamD,MohantaT,SwainAR,etal.

Adistributedsystemdesignfornextgenerationstorageandremotereplication[C]//Procofthe5thInternationalConferenceonApplicationsofDigitalInformationandWebTechnologies.

2014:2227.

[6]张冬.

大话存储Ⅱ———存储系统架构与底层原理极限剖析[M].

北京:清华大学出版社,2011:603613.

[7]DeLucaA,BhideM.

Storagevirtualizationfordummies[M].

[S.

l.

]:WileyPublishingAustraliaPtyLtd,2009:5053.

[8]SuWenchi,ChangSE.

Integratedcloudstoragearchitectureforenhancingservicereliability,availabilityandscalability[C]//ProcofInternationalConferenceonInformationScience,ElectronicsandElectricalEngineering.

2014:764768.

[9]MeiLijun,ChanWK,TseTH.

Ataleofclouds:paradigmcomparisonsandsomethoughtsonresearchissues[C]//ProcofAsiaPacificServicesComputingConference.

2008:464469.

[10]ItzhackG,SondhiN.

Storagethinprovisioningandspacereclamation:U.

S.

PatentNo.

9,329,792[P].

20160503.

[11]Kawaguchi,Tomohiro.

Highavailabilityandlowcapacitythinprovisioning:U.

S.

PatentApplication12/053,514[P].

20080321.

[12]E2fsprogs:ext2/3/4filesystemutilities[EB/OL].

(20101022)[20150312].

http://e2fsprogs.

sourceforge.

net/.

[13]Masterbootrecord[EB/OL].

(2015)[20150510].

http://wiki.

archlinux.

org/index.

php/Master_Boot_Record.

[14]GUID_partition_table[EB/OL].

(2015)[20150510].

https://wiki.

archlinux.

org/index.

php/GUID_Partition_Table.

·5691·第7期张小炳,等:基于均衡性和可达性的高速铁路列车停站方案优化

- 文件系统南京虚拟主机相关文档

- 竞赛南京虚拟主机

- 南京商业学校核心路由简介

- 课程南京虚拟主机

- 虚拟主机租用合同甲方

- 计算南京虚拟主机

- 指令南京虚拟主机

福州云服务器 1核 2G 2M 12元/月(买5个月) 萤光云

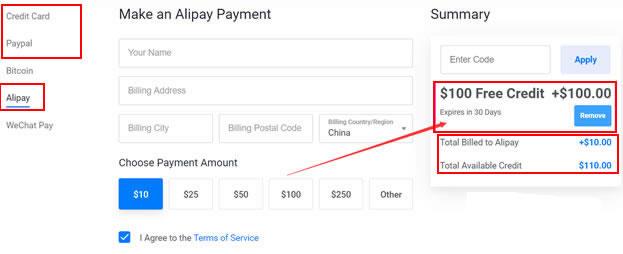

厦门靠谱云股份有限公司 双十一到了,站长我就给介绍一家折扣力度名列前茅的云厂商——萤光云。1H2G2M的高防50G云服务器,依照他们的规则叠加优惠,可以做到12元/月。更大配置和带宽的价格,也在一般云厂商中脱颖而出,性价比超高。官网:www.lightnode.cn叠加优惠:全区季付55折+满100-50各个配置价格表:地域配置双十一优惠价说明福州(带50G防御)/上海/北京1H2G2M12元/月...

Vultr新注册赠送100美元活动截止月底 需要可免费享30天福利

昨天晚上有收到VULTR服务商的邮件,如果我们有清楚的朋友应该知道VULTR对于新注册用户已经这两年的促销活动是有赠送100美元最高余额,不过这个余额有效期是30天,如果我们到期未使用完的话也会失效的。但是对于我们一般用户来说,这个活动还是不错的,只需要注册新账户充值10美金激活账户就可以。而且我们自己充值的余额还是可以继续使用且无有效期的。如果我们有需要申请的话可以参考"2021年最新可用Vul...

SpinServers(月89美元) 2*e5-2630L v2,美国独立服务器

SpinServers服务商也不算是老牌的服务商,商家看介绍是是2018年成立的主机品牌,隶属于Majestic Hosting Solutions LLC旗下。商家主要经营独立服务器租用和Hybrid Dedicated服务器等,目前包含的数据中心在美国达拉斯、圣何塞机房,自有硬件和IP资源等,商家还自定义支持用户IP广播到机房。看到SpinServers推出了美国独服的夏季优惠促销活动,最低月...

南京虚拟主机为你推荐

-

桌面背景图片风景推荐个电脑桌面壁纸少儿英语哪个好少儿英语哪个好少儿英语哪个好少儿英语哪套教材好哪里好呢?手机杀毒软件哪个好手机安全杀毒软件哪个比较好些?手机管家哪个好手机管家哪个软件好网校哪个好有什么网校比较好网络机顶盒哪个好什么牌子的网络机顶盒最好腾讯空间登录QQ空间登录qq空间登录电脑手机怎么登qq空间电脑版?电信10000宽带测速怎样测试电信宽带的网速? 771212