优化ai内存不足

YOURSUCCESS,WESUCCEED基于GPU的AI计算优化方法与案例:从训练到推理张清,浪潮AI首席架构师AI计算的发展趋势及其挑战基于GPU的AI计算优化方法:从训练到推理提纲CaseStudy:基于GPU实现AutoMLSuite计算优化Source:IDC2019AI计算的发展趋势US$M2,731.

74,478.

96,833.

89,674.

413,432.

317,468.

01,680.

62,686.

63,762.

94,639.

05,917.

67,303.

464.

0%52.

6%41.

6%38.

8%30.

0%59.

8%40.

0%23.

3%27.

6%23.

4%0.

0%10.

0%20.

0%30.

0%40.

0%50.

0%60.

0%70.

0%02,0004,0006,0008,00010,00012,00014,00016,00018,000201820192020202120222023中国人工智能总体市场规模及预测,2018-2023AISpendingGrowthRate整体投资中国人工智能服务器市场规模及预测,2018-2023AIServerGrowthRate算力投资趋势1:越来越多的场景将采用AI技术创新,未来计算投入会越来越大81.

3%73.

7%66.

6%59.

8%51.

7%47.

9%42.

7%18.

7%26.

3%33.

4%40.

2%48.

3%52.

1%57.

3%0%10%20%30%40%50%60%70%80%90%100%2017年2018年2019年2020年2021年2022年2023年TrainingInferenceSource:IDC2019AI计算的发展趋势趋势2:越来越多的AI应用将进入生产阶段,未来5年推理所需计算会迅速增加Source:FacebookAI计算的发展趋势趋势3:大数据+大模型,需要更大的计算16.

036.

087.

0153.

082.

2%84.

2%85.

1%85.

4%80.

0%81.

0%82.

0%83.

0%84.

0%85.

0%86.

0%020406080100120140160180200ResNeXt-10132*8dResNeXt-10132*16dResNeXt-10132*32dResNeXt-10132*48d单位:BFLOPS计算量准确度AI计算面临的挑战AI计算架构:芯片间异构与芯片内异构异构并行与协同计算–CPU/GPU,CUDACore/TensorCoreAI计算规模:K级节点、10K级GPU卡性能与性能的可扩展性–单模型K级以上GPU并行计算AI计算环境:不同用户、不同算法、不同数据、不同框架、不同GPU卡任务管理与资源调度–生产系统K级以上模型并发调度不同AI计算的发展趋势及其挑战基于GPU的AI计算优化方法:从训练到推理提纲CaseStudy:基于GPU实现AutoMLSuite计算优化基于GPU的AI计算优化方法AI应用特征分析GPU平台优化AI计算框架GPU优化AI应用GPU优化计算特征访存特征通信特征IO特征计算优化存储优化网络优化资源管理资源调度GPU系统管理优化数据模型划分单机优化算法不同通信机制数据模型聚合训练性能优化训练扩展优化推理吞吐优化推理延时优化AI应用特征分析CPUGPUTeye工具:从微架构层次分析AI应用与框架特征,实现性能优化MXNetTensorFlowCaffeCV应用特征分析案例CPU利用率:5%-25%CPU内存:20GB以下GPU利用率:80%-100%GPU内存:15GB左右GPU平台优化计算优化–训练:单机8-16V100GPU并行–推理:单机8-16T4GPU并行网络优化–训练:单机4-8个IB卡(100GB/s-200GB/s)实现1000卡以上并行–推理:单机万兆网络通信优化–训练:NVSwitch+RDMA–推理:PCIE存储优化:高性能并行存储+SSD/NVMe两级存储547.

23889.

64456.

811076.

551761.

27907.

392065.

93399.

91805.

034124.

376813.

023581.

968195.

8313473.

36976.

06050001000015000resnet101resnet50vgg16V100-SMX332GBbs=256(Images/s)(InspurAGX-5)1GPU2GPUs4GPUs8GPUs16GPUs6134077903102741020000400006000080000100000120000A厂商8*PCIeGPUServerB厂商8*NVLinkGPUServerInspur5488M5NLPTransformerBenchmark(每秒钟训练单词数)GPU系统管理优化数量:120GPU分配:共享用途:训练用户:ALLSSD缓存HAP100_share数量:96GPU分配:独享用途:训练用户:行为分析SSD缓存P100_exclusive数量:64GPU分配:共享用途:训练用户:ALLSSD缓存V100_share数量:120GPU分配:独享用途:训练用户:图像识别SSD缓存V100_exclusive用户数据:代码,模型云存储数量:32GPU分配:共享用途:开发调试,镜像定制用户:ALLSSD缓存P40_debug利用AIStation实现统一资源管理和调度–大规模AI生产平台:800+GPU卡–GPU利用率40%提升到80%–作业吞吐提升3倍训练数据下载AI计算框架GPU优化并行机制:数据并行/模型并行/数据+模型并行/Pipline并行GPU计算充分发挥:FP16与FP32混合精度计算,保持训练稳定下的大batchsize训练计算梯度同步通信机制:异步或半异步,ring-allreduce,2D-Torusall-reduce通信优化:合并小数据,提升通信效率;计算与通信异步,实现隐藏通信并行IO,采用多线程的数据读取机制数据预取、数据IO与计算异步并行IOAI计算框架GPU优化案例开源地址:https://github.

com/Caffe-MPI/Caffe-MPI.

github.

ioNo.

ofGPUsimages/sNo.

ofGPUsInspurCaffe-MPIInspurTensorFlow-Opt实现512块GPU24分钟完成imagenet数据集训练基于HPC架构,实现数据并行,并行IO读取数据基于NCCL,并采用环形通信方式计算与通信异步,实现计算与通信的异步隐藏实现主从模式到对等模式通信合并梯度,提升通信效率采用fp16通信,减少通信量AI应用面临的挑战分析及优化思路数据跟不上计算,GPU利用率低模型和数据大,GPU显存溢出,如何优化混合精度如何优化,TensorCore如何高效利用如何快速实现多机多GPU卡并行计算Pref/NVProfTensorflow-timelineHorovod-timelineTeyeGPU-driver/CUDA/cuDNN/NCCL计算框架版本匹配CPU/GPU端、Bios设置CPU与GPU、GPU与GPU、节点间通信拓扑应用瓶颈分析GPU系统级优化GPU代码级优化训练的性能训练的扩展效率推理的吞吐量推理的延时AI训练应用GPU优化方法数据IO优化数据格式、数据存储、数据处理、数据流水线混合精度优化使用CUDACore&TensorCore发挥GPU使用效率GPU并行优化使用ring(tree)-allreduce高效并行通信方式数据IO优化数据并行读取数据并行批量预处理数据与计算异步并行数据IO优化案例1某图像识别CNN模型(在P100平台训练)实测单卡计算性能只有2.

3TFlops,远低于P100的理论单精度浮点性能;分析GPU的利用率,发现GPU只有60%左右的时间在参与计算,剩余40%的时间处于空闲状态;在毫秒尺度观察GPU的使用情况,发现有周期性的0.

06s左右的GPU空闲时间数据IO优化案例1效果通过优化图片预处理方式,可以有效的提高GPU资源的利用率,优化后GPU的使用率提升到90%左右.

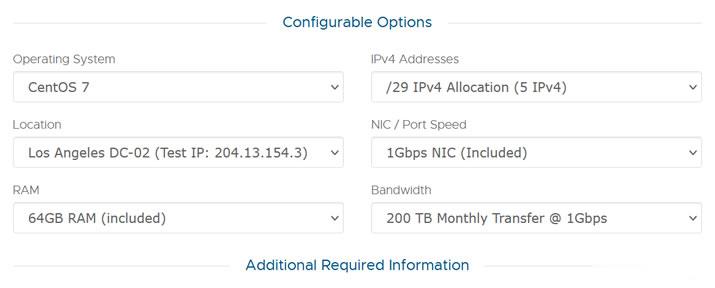

月费$389,RackNerd美国大硬盘独立服务器

这次RackNerd商家提供的美国大硬盘独立服务器,数据中心位于洛杉矶multacom,可选Windows、Linux镜像系统,默认内存是64GB,也可升级至128GB内存,而且硬盘采用的是256G SSD系统盘+10个16TSAS数据盘,端口提供的是1Gbps带宽,每月提供200TB,且包含5个IPv4,如果有需要更多IP,也可以升级增加。CPU核心内存硬盘流量带宽价格选择2XE5-2640V2...

GigsGigsCloud:$16/月KVM-1GB/30GB/1TB/1.6T高防/洛杉矶CN2 GIA+AS9929

GigsGigsCloud是一家成立于2015年老牌国外主机商,提供VPS主机和独立服务器租用,数据中心包括美国洛杉矶、中国香港、新加坡、马来西亚和日本等。商家VPS主机基于KVM架构,绝大部分系列产品中国访问速度不错,比如洛杉矶机房有CN2 GIA、AS9929及高防线路等。目前Los Angeles - SimpleCloud with Premium China DDOS Protectio...

UCloud年度大促活动可选香港云服务器低至年134元

由于行业需求和自媒体的倾向问题,对于我们个人站长建站的方向还是有一些需要改变的。传统的个人网站建站内容方向可能会因为自媒体的分流导致个人网站很多行业不再成为流量的主导。于是我们很多个人网站都在想办法进行重新更换行业,包括前几天也有和网友在考虑是不是换个其他行业做做。这不有重新注册域名重新更换。鉴于快速上手的考虑还是采用香港服务器,这不腾讯云和阿里云早已不是新账户,考虑到新注册UCLOUD账户还算比...

-

网络域名注册怎么注册网络域名并建立自己的网站呢海外虚拟主机空间国外虚拟主机空间为什么能这么大呢?独立ip空间大家都来看看,下面哪个独立IP空间好域名代理怎么通过域名赚钱租服务器租服务器是什么意思?英文域名求好听的个性英语域名?免费国外空间哪里的国外免费空间好?免费网站域名申请哪里可以申请到免费网站域名?查询ip怎样查别人的ip地址?台湾主机香港,美国,台湾,韩国,日本主机到底哪个好