海量数据挖掘雷网主机如何应对海量数据的挑战?

海量数据挖掘 时间:2021-05-27 阅读:()

谁知道去哪得到海量数据啊,最近要做个数据挖掘的软件,急急急求

数据堂吧。。

这个网站算是提供很多数据 还有你要是想要正规的话 只能搜索一些大型比赛数据和一些顶级论文中引用的数据。

。

关键,你要对你做的领域熟悉

什么是数据挖掘?

1)首先,数据挖掘-Data Mining不是一个骗局,而是一种还处于发展中,已经投入部分投入实际生产实践的技术框架。DM之所以经常和知识发现概念相关联是因为知识发现(Knowledge Discovery)是DM的目标和产出(output)。

随着信息化应用的普及,传统的交易性数据(Transaction),比如:你在超市购物,产生了一笔交易,这笔交易会在现有的数据库系统中存储下来,随着时间的累计,这种数据变得海量。

面对这些海量数据,这其中是否存在一些可以更好帮助决策的东西。

比如:什么产品的搭配拜访可能会提高销量,我超市的用户可能都是出于什么消费水平?。

注意:我这里用到“可能”字眼,意味着决策需要用到历史数据的支持来降低未来决策的风险(提高可能性)。

而实际上,比如:沃尔玛和一些大型金融机构使用数据挖掘的产品和工具都超过了二十年,而且产生了期望的效应,而国内电信、金融行业从2005年以后逐渐加大了相关的投入。

因此,如果DM是一个骗局,那被忽悠的都是全球最顶尖的公司和最顶尖的IT管理人员。

2)数据(Data)-信息(information)-知识(Knowledge)是一个递进的关系。

数据的电子化产生了信息,比如:我们可以通过SQL语句检索到我们要的信息,但是我们无法用简单的SQL语句找到我们需要的知识,比如:我想知道某种型号面包的销售是否存在季节性因素和扰动,这就需要专门的统计分析工具和算法,而在某些命题常规统计学方法不能奏效的时候,就可能需要用到一些更复杂的工具和算法,比如:随机过程,神经网络等。

3)数据挖掘的步骤一般可以分为:数据提取(ETL)-数据仓库-数据挖掘工具-知识发现。

当然这些挖掘的结果很多时候是令人无法接受,或者不能理解的,但是DM提供的是基于某种算法下的或然性(可能性),还需要与具体的业务逻辑相结合,因此数据挖掘应用效果的核心不是工具和平台的先进,而是对现有企业的业务知识和市场战略把握、决策方法等相关联的事情。

此类项目失败的风险远远高于普通IT项目的最大原因在于历史数据的不完整(早期系统设计上的缺陷等),实施队伍的不专业,业务知识梳理能力低下。

其中最核心的可能在于实施此类项目对于人员的要求较高,而很多企业的IT部门,以及承当项目的公司显然不具备这样的团队。

希望可以帮你理解DM。

雷网主机如何应对海量数据的挑战?

各巨头的数据量级大曝光 百度威廉.张表示,“数百PB,每一天需要处理的数据是数十个TB,许多数据要在几秒钟之内处理,很多数据在几分钟之内要处理,更多的是几个小时之内处理就够了,几个小时处理数十个PB的数据,也是很困难的。所有的策略都是针对实时性和数据处理的时效性理来做的。

互联网用户的需求是更加实时,如微博、团购、秒杀等,所以说实时处理十分重要。

” Yahoo!周轶平谈道,“雅虎的云计算平台综述超过三万台机器,最大的超过4000太左右,总存储容量超过了100PB。

”他表示,雅虎最近放了很多精力在保护用户的隐私和数据安全性上,欧盟规定雅虎不能够存储用户的数据超过一百天,虽然不能保存,但是雅虎做很深入的数据挖掘,从数据瓦局得到一些真正有价值的信息,并把这些信息保存下来。

” SAP杜涛也介绍了其需要帮助客户处理的数据量的级别,“SAP作为企业级应用的提供商,更关注客户的数据量是多少,这些客户包括中小型企业到大型的客户,其中有数据密集型的企业,如电信、金融、政府、零售等等,客户的数量级包括从几个TB到数百个TB。

”同时,SAP自己有一个很大的数据中心,主要是为SAP的客户提供服务,有三万台服务器,数据量大概是15TB并且有越来越多的客户的数据会在SAP的数据中心。

如何存储并利用这些海量的数据? 如此海量的数据,如何进行存储、分析、处理?并基于海量数据的挖掘,为企业创造更大的商业价值?针对海量数据的挖掘的技术架构,几位专家分别介绍了自己的法宝。

SAP杜涛从两个方面介绍SAP的海量数据处理方法,“一方面,在SAP的数据中心,采用了标准的云计算所用的虚拟化和分布式存储;另一方面,针对单独的企业,SAP在4月16号在德国发生了内存计算技术。

海量数据的读取和分析,在传统的架构下,基于磁盘的IO是以毫秒级来计算的,而在内存RAM中处理时间是nm级的。

所以SAP把客户的数据经过压缩的处理放到内存中去,进行读取和分析,把之前在应用层的分析放到内存里面去做,提升性能,帮助用户充分利用他们的数据。

” Yahoo!的云计算的体系是以Hadoop为中心的,周轶平介绍到,并从数据采集(HDFS)、数据存储和处理、数据服务三个层面入手,介绍了雅虎的海量数据处理的方案。

数据采集方面,yahoo建立了Data Have负责从雅虎遍布全球数据中心中的几十万台机器上实时收集数据,它有2个干道,主干道负责把数据以很高的一致性经过各种过滤清理以后,放到Hadoop的平台上。

但是这样的处理方法实时性不是很高,为了满足实时性的需求,还有一个旁道系统,能够在秒级直接将数据源导入到Hadoop上。

雅虎的数据处理都是基于Hadoop的实时的服务,同时Yahoop还有一套很大的不同业务逻辑所需求的服务系统,超过一半的数据处理都是使用Hadoop Pig数据引擎。

百度威廉.张表示,面对互联网的云计算,大搜索是基于索引的,如何对数据进行实时地快速的更新,就需要进行一些优化。

比如说根据数据更新的频率,建立在更新系统快或是更新系统慢的系统之上,根据地域的登录跟重要性的登录把它放到南方或者是北方的机房里,也就是说,主要是根据数据的应用来策略。

机器学习的算法,内存里面的数据进行高复杂度的计算,可能要花费很长的时间,这在百度的环境中是不行的,无论是判断用户的需求、从用户行为中得知需要推荐什么内容和什么广告,这些都需要非常高的时效性和极规模的机器学习。

- 海量数据挖掘雷网主机如何应对海量数据的挑战?相关文档

- 海量数据挖掘本人想考研,想学习商业智能BI'数据挖掘方面,海量数据+算法+云,哪个学校这方面专业好点?

- 海量数据挖掘如何处理海量数据

- 海量数据挖掘大数据和数据挖掘什么区别?

- 海量数据挖掘大数据和数据挖掘是什么关系

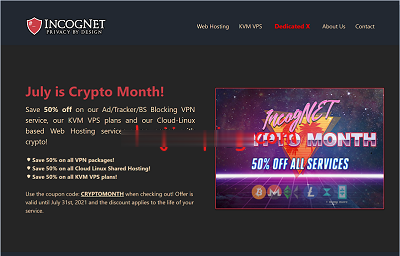

incogne$2.5/月t芬兰VPS,AMD Ryzen、1Gbps带宽

IncogNet LLC是个由3个人运作的美国公司,主要特色是隐私保护,号称绝对保护用户的隐私安全。业务涵盖虚拟主机、VPS等,支持多种数字加密货币、PayPal付款。注册账号也很简单,输入一个姓名、一个邮箱、国家随便选,填写一个邮箱就搞定了,基本上不管资料的真假。当前促销的vps位于芬兰机房,全部都是AMD Ryzen系列的CPU,性能不会差的!5折优惠码:CRYPTOMONTH,支持:BTC,...

inlicloud48元/月,云主机,2核1G/200Mbps,可选安徽/上海联通/广州移动/江门移动NAT

inlicloud怎么样?inlicloud(引力主机)主要产品为国内NAT系列VPS,目前主要有:上海联通NAT(200Mbps带宽)、宿州联通NAT(200Mbps带宽)、广州移动NAT(200Mbps带宽)。根据官方的说法国内的NAT系列VPS不要求备案、不要求实名、对中转要求也不严格,但是,禁止任何形式的回国!安徽nat/上海联通/广州移动/江门移动nat云主机,2核1G/200Mbps仅...

pacificrack:2021年七夕VPS特别促销,$13.14/年,2G内存/2核/60gSSD/1T流量,支持Windows

pacificrack官方在搞2021年七夕促销,两款便宜vps给的配置都是挺不错的,依旧是接入1Gbps带宽,KVM虚拟、纯SSD raid10阵列,支持包括Linux、Windows 7、10、server2003、2008、2012、2016、2019在内多种操作系统。本次促销的VPS请特别注意限制条件,见本文末尾!官方网站:https://pacificrack.com支持PayPal、支...

海量数据挖掘为你推荐

-

小米云服务器登录你好 我想咨询下 要登录小米云服务除了手机信息验证还有其他方法吗?虚拟主机什么用电脑中的虚拟机是干什么用的 有什么作用虚拟主机下载求虚拟机下载地址?华为云服务找回手机我的华为手机刚刚丢了,处于关机状态下可以定位找回吗可靠云主机比阿里云更靠谱的备案的云主机有吗?那好上海哪里好找工作?好看的表格样式创意如何使用PS快速制作美观的表格好看的表格样式创意怎样使用excel制作漂亮的表格ddos防御怎样防御DDOS攻击?香港亚马逊官网网址香港人在网上买东西,都是在什么网站上买东西?